机构名称:

¥ 2.0

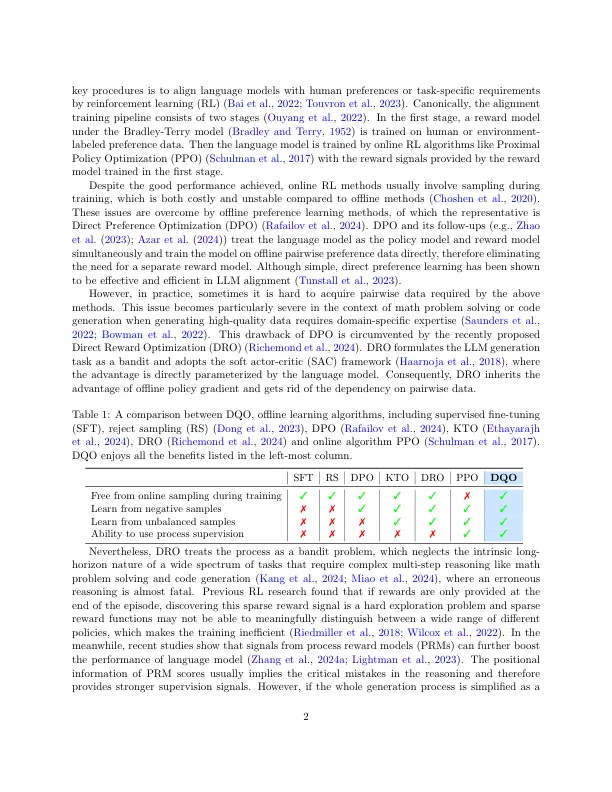

强化学习(RL)在使大语言模型(LLMS)与人类偏好相结合并提高其执行复杂任务的能力方面起着至关重要的作用。但是,由于使用多种模型和大量的在线抽样培训(例如PPO),当前的方法要么需要大量的计算资源(例如,PPO),要么被用作匪徒问题(例如,DPO,DRO),通常在多步理学任务中挣扎,例如数学问题和复杂的推理,涉及较长的思想链条。为了克服这些局限性,我们引入了直接的Q-功能优化(DQO),该优化将响应生成过程作为马尔可夫决策过程(MDP),并利用软actor-Critic(SAC)框架来优化语言模型直接参数参数的Q函数。DQO的MDP公式提供了比基于匪徒的方法的结构优势,从而实现了更有效的过程监督。对两个数学解决问题数据集GSM8K和数学的实验结果表明,DQO胜过以前的方法,将其确定为一种有希望的离线强化学习方法,以使语言模型对齐。

通过直接Q功能优化增强语言模型的多步推理能力

主要关键词