机构名称:

¥ 1.0

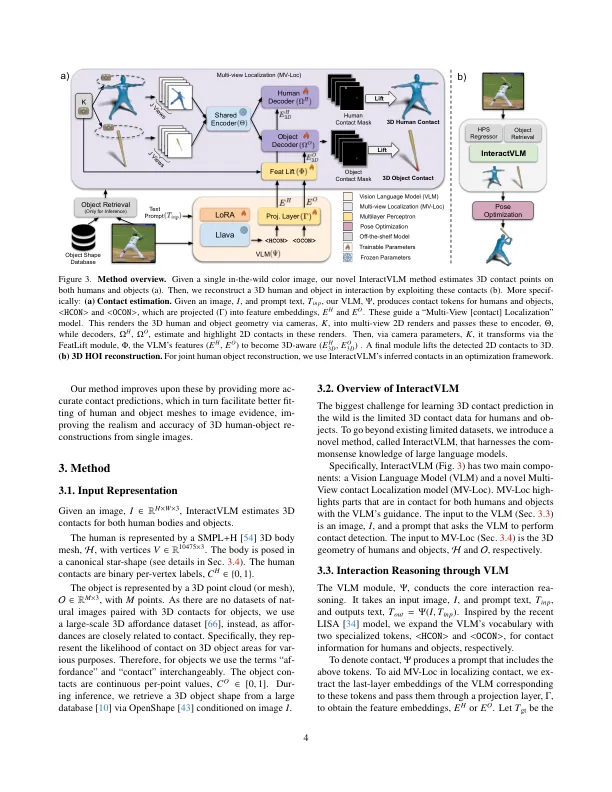

估计相互作用的人类的3D姿势和形状以及来自单个野外图像的物体对于混合现实和机器人技术很重要。由于阻塞,深度歧义和广泛变化的物体形状,这具有挑战性。现有工作通过利用身体和物体上的表面接触点并使用这些来指导3D重建来应对这些挑战。不幸的是,获得3D接触注释需要昂贵的3D地面真相或耗时的手动标签。,根据大规模获取培训数据是一个挑战。我们通过开发一种称为InteractVLM的新型模型来解决此问题,该模型利用大型视觉语言模型(VLM)的广泛视觉知识。问题是,这些大型模型并未直接“理解” 3D人类对象接触。为了解决这个问题,我们利用了3D人类对象交互的现有小型数据集来微调大型模型以了解接触。但是,这是非平凡的,因为这种模型仅在2D中“仅”,而触点是继承的3D。因此,我们引入了一个新颖的“ RenderLecalize-Lift”模块,该模块:(1)通过多视图渲染将3D主体和物体表面嵌入2D空间,(2)训练一种新型的多视图本地化模型(MV-LOC),以推断2D,

来自2D基础模型的3D相互作用推理

主要关键词