机构名称:

¥ 1.0

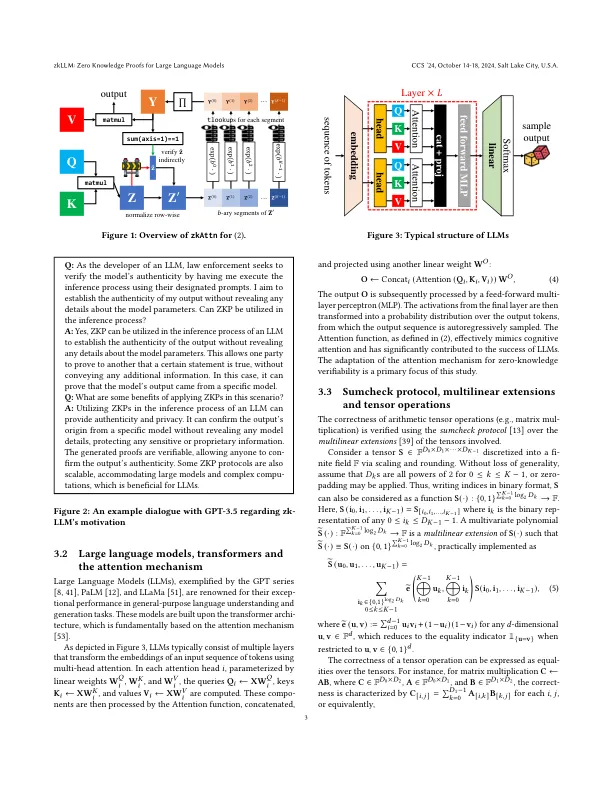

最近的人工智能(AI)激增,其特征是大型语言模型(LLM)的突出性,已迎来了全球的基本转变。,除了这些进步之外,围绕LLMS合法性的担忧已经增长,对其广泛的应用构成了法律挑战。加剧了这些关注点,LLM的参数通常被视为知识产权,限制了直接调查。在本研究中,我们解决了AI立法领域中的基本挑战:建立LLMS产生的产出的真实性的必要性。为了解决这个问题,我们提出了ZKLLM,它是为我们所知的为LLMS量身定制的首届专业零知识证明。解决深度学习中非偏心操作的持续挑战时,我们介绍了Tlookup,这是一个平行的查找参数,专为深度学习中的非偏振量张量操作而设计,提供了一个没有渐近性高架的解决方案。此外,在利用Tlookup的基础上,我们介绍了Zkattn,这是一种专门的零知识证明,为注意机制而设计,精心平衡运行时间,内存使用和准确性的考虑。在我们完全并行的CUDA实现的能力下,ZKLLM旨在在LLMS上实现有效的零知识可验证计算的重要大步。非常重要的是,对于拥有130亿个参数的LLMS,我们的方法可以在15分钟内为整个推理过程提供正确的证明。由小于200 kb的最终证明旨在维护模型参数的隐私,从而确保没有无意的信息泄漏。

zkllm:大语言模型的零知识证明

主要关键词