机构名称:

¥ 1.0

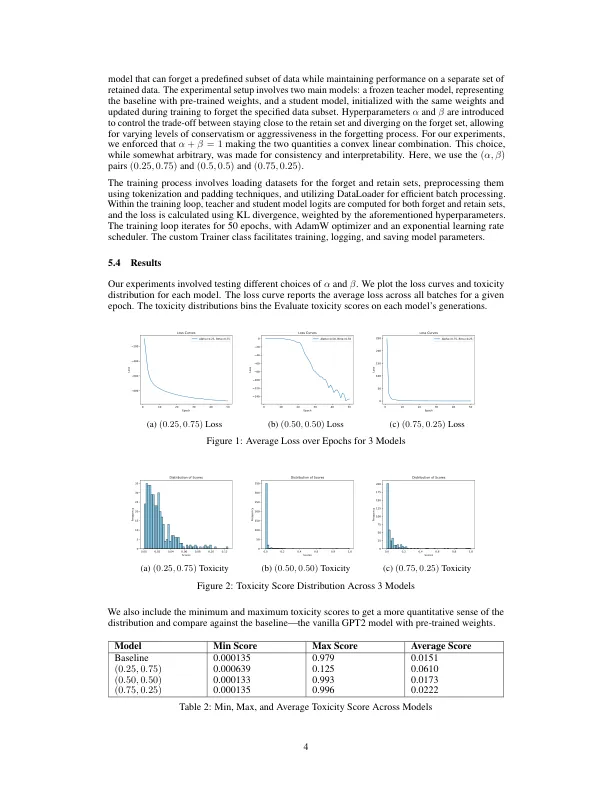

机器学习,模型可以“忘记”其训练数据的一个子集的能力,在各个领域都具有实际含义。的确,在各种情况下,这种方法可能是无价的,例如消除偏见和保护用户隐私,在这种情况下,将模型撤离(确切的学习)可能在计算上很昂贵或笨拙。我们的目标是基于学生教师模型实施机器,并将其扩展到大型语言模型,例如OpenAI的GPT-2。我们提出了一个受灌木算法启发并适用于LLM的目标函数,试图在指定的忘记设置上学习,同时在其他地方保留绩效。发现了多个有趣的发现:变化的超参数和填充物产生了一个未对准的模型,该模型成功地针对目标函数进行了优化,但其实践中的产生是次优的。其他模型要么泄漏了潜在的不良数据,要么表现出比基线更高的偏差。

探索机器在大语言模型中学习