机构名称:

¥ 9.0

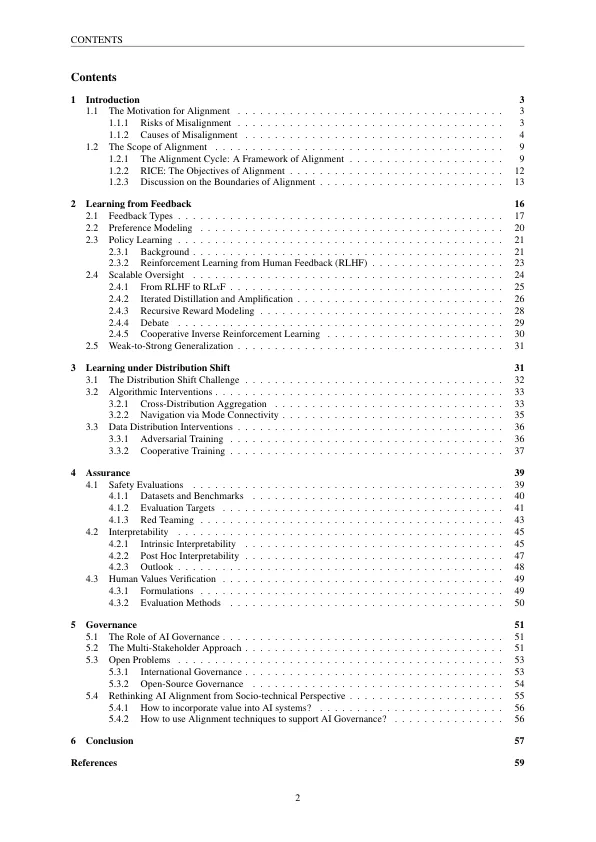

AI一致性旨在使AI系统符合人类的意图和价值观。随着AI系统的发展越来越强大,因此未对准的风险也会出现。为了提供对齐字段的全面,最新的概述,在本调查中,我们深入研究了对齐的核心概念,方法论和实践。首先,我们将四个原则确定为AI一致性的关键目标:鲁棒性,可解释性,可控性和道德(大米)。在这四个原则的指导下,我们概述了Currant Alignment Research的景观,并将它们分解为两个关键组成部分:远程对齐和后方对齐。前者的目的是通过对齐培训使AI系统保持一致,而后者则旨在获得有关系统对齐的证据,并适当地管理它们,以避免加剧未对准风险。在向前对齐时,我们讨论了在分配转移中从反馈和学习中学习的技术。具体来说,我们调查了传统的偏好建模方法和从人类反馈中进行的增强学习,并进一步讨论了潜在的框架,以实现可扩展的监督,以实现有效的人类监督的任务。在分配转移的学习中,我们还涵盖了数据分布干预措施,例如对抗培训,这些干预措施有助于扩大培训数据的分布以及算法干预措施,以打击目标不良的杂草差异化。在向后对齐时,我们讨论了保证技术和治理实践。具体来说,我们在其整个生命周期中调查了AI系统的保证方法,涵盖了安全评估,可解释性和人为价值的依从性。我们讨论了旨在管理现有和未来AI风险的政府,行业行为者和其他第三方采用的当前和潜在治理实践。

A Comprehensive Survey - AI Alignment

主要关键词