机构名称:

¥ 1.0

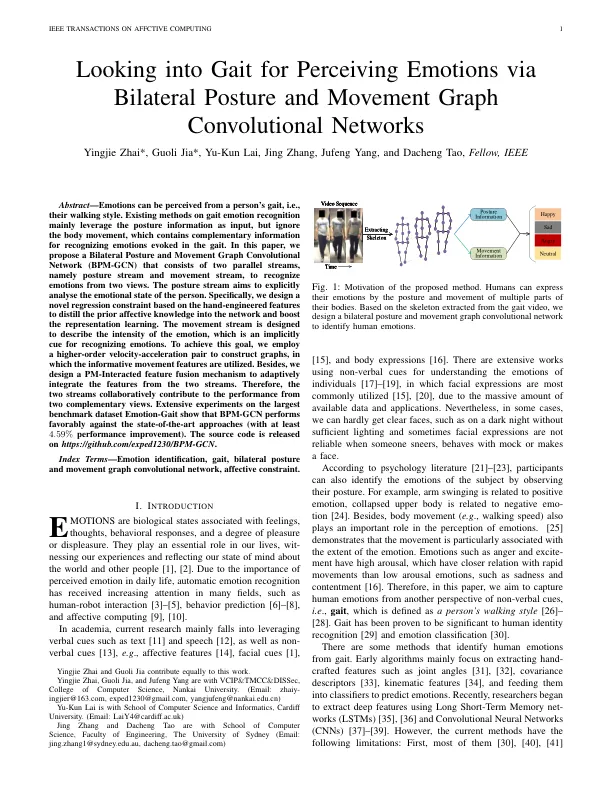

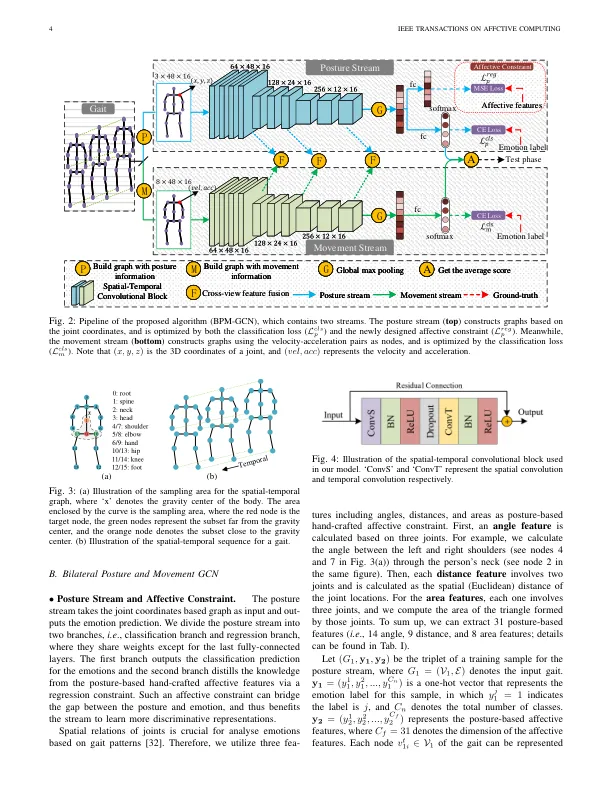

摘要 - 情绪可以从一个人的步态(即他们的步行风格)中感知。关于步态情绪识别的现有方法主要利用姿势信息作为输入,但忽略了身体运动,其中包含互补信息,以识别步态中引起的情绪。在本文中,我们提出了一个双边姿势和运动图卷积网络(BPM-GCN),该网络由两个平行流组成,即姿势流和运动流,以识别两种观点的情绪。姿势流旨在明确分析人的情绪状态。具体来说,我们根据手工设计的功能设计了一种新颖的回归约束,以将先前的情感知识提炼到网络中并增强表示形式学习。运动流旨在描述情感的强度,这是识别情绪的隐含提示。为了实现这一目标,我们采用了一个高阶速度加速对来构建图形,其中使用了信息性运动功能。此外,我们设计了PM相互作用的特征融合机制,以适应两条流的特征。因此,这两个流从两个互补视图中协作为性能做出了贡献。在最大的基准数据集情绪基准上进行的广泛实验表明,BPM-GCN对最先进的方法表现出色(至少有4个。59%的绩效提高)。源代码在https://github.com/exped1230/bpm-gcn上发布。

纸 - ORCA - 在线研究 @ Cardiff

主要关键词