机构名称:

¥ 1.0

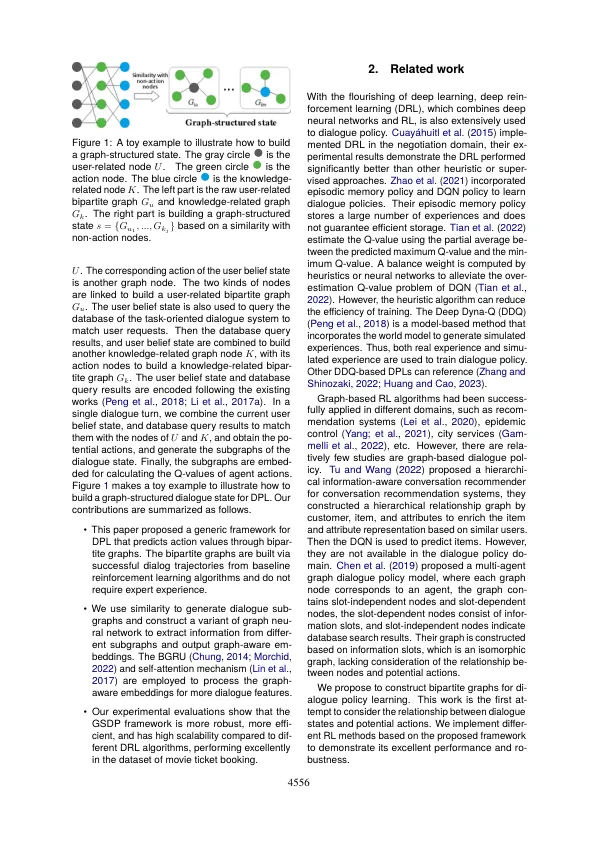

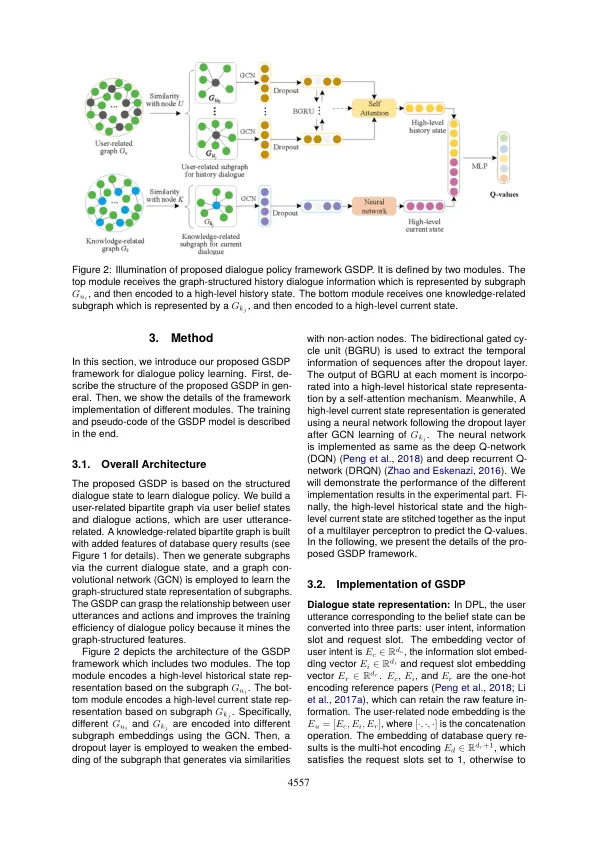

抽象的深入强化学习(DRL)已成功应用于以任务为导向的对话系统的对话政策。但是,现有的基于DRL的对话策略方法中的一个挑战是它们的非结构化状态行动表示,没有能力学习对话状态与行动之间的关系。为了减轻此问题,我们为以任务为导向的对话系统提出了图形结构化对话策略框架。更具体地说,我们使用一种无监督的方法来构建两个不同的两部分图。然后,我们基于与双分部分图节点的匹配对话子群生成与用户相关的和知识相关的子图。使用图形卷积网络的变体来编码对话子图。之后,我们使用双向封闭式周期单元(BGRU)和自我发项机制来获得高级历史状态表示,并采用神经网络来获得高级当前状态表示。两种状态表示形式被加入以了解对话策略的行动价值。用不同的DRL算法实施的实验表明,所提出的框架显着提高了对话策略的有效性和稳定性。

深度强化学习基于图形卷积Q-network的对话政策

主要关键词