机构名称:

¥ 1.0

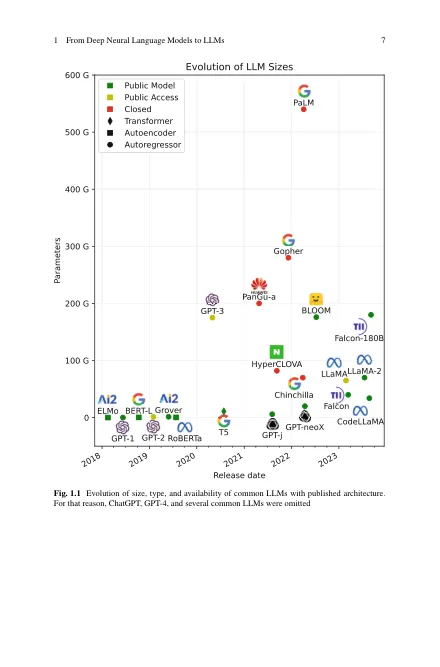

此定义直接遵循了第一个介绍“大语言模型”概念的论文:[1,2],并代表了LLMS功能平稳缩放的规模,因为它们的大小从100m增加到1000b参数[3,4]。此定义意味着虽然原始变压器不是LLM,但基于RNN的Elmo是。同样,通常用于文本分类而不是生成的BERT模型是LLM,就像翻译调节的T5一样。在LLM系列中包括较小的模型,我们还可以将历史上视为LLM的模型包括在内,例如具有6600万参数的Distilbert,甚至具有12M参数的Codex模型。同样,这意味着我并没有区分LLM与生成代码,二进制,通过搜索引擎请求或接受图像作为输入的文本的文本。

从深度神经语言模型到LLMS