机构名称:

¥ 3.0

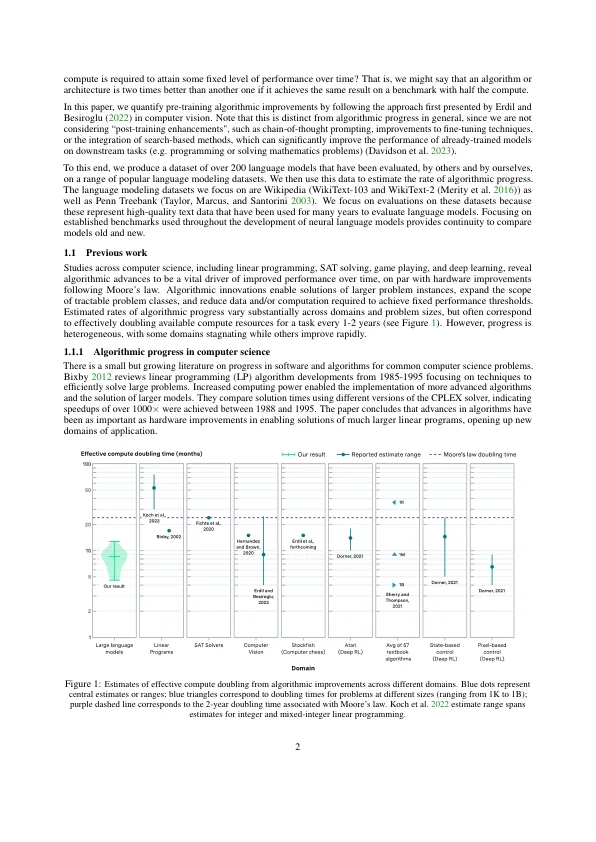

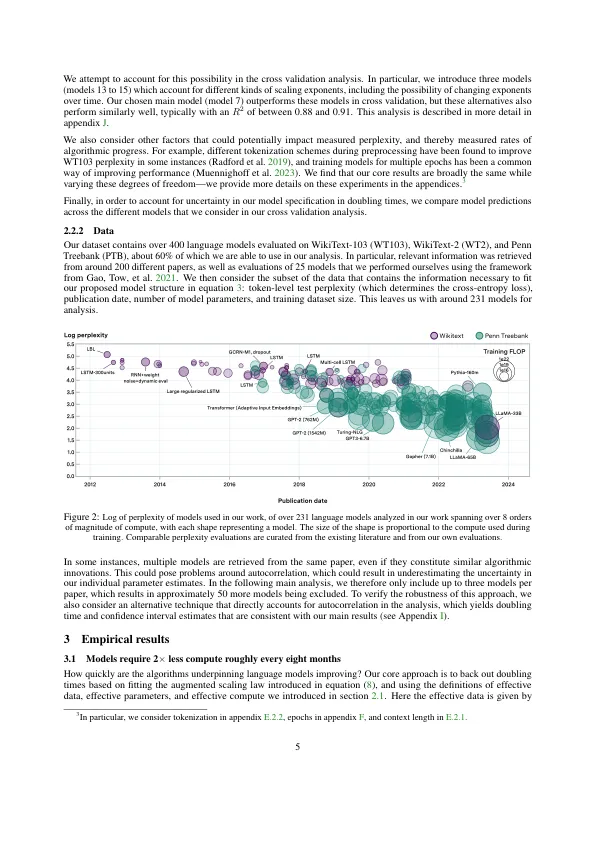

我们调查了自深度学习出现以来,培训前语言模型的算法有所改善的速率。使用跨越2012 - 2023年Wikitext和Penn Treebank上200多个语言模型评估的数据集,我们发现达到设定性能阈值所需的计算大约每8个月减半,而95%的置信区间的95%置信区间约为5到14个月,大约比摩尔法律的硬件加快了。我们估计了扩大缩放定律,这使我们能够量化算法进度,并确定缩放模型与培训算法中创新的相对贡献。尽管算法进步的速度快速发展和诸如变压器等新体系结构的发展,但我们的分析表明,计算的增加在这段时间内对整体绩效改善做出了更大的贡献。虽然受嘈杂的基准数据限制,但我们的分析量量化了语言建模的快速进步,从而阐明了计算和算法的相对贡献。

语言模型中的算法进度