机构名称:

¥ 1.0

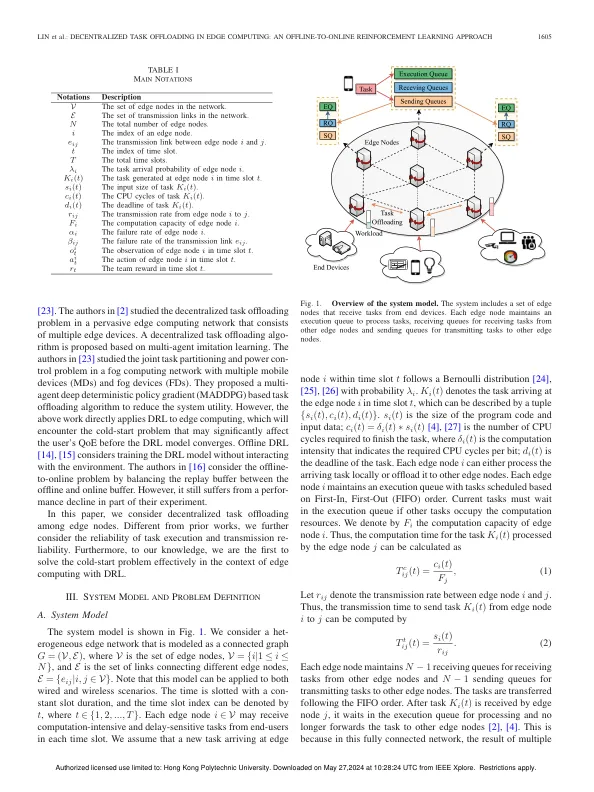

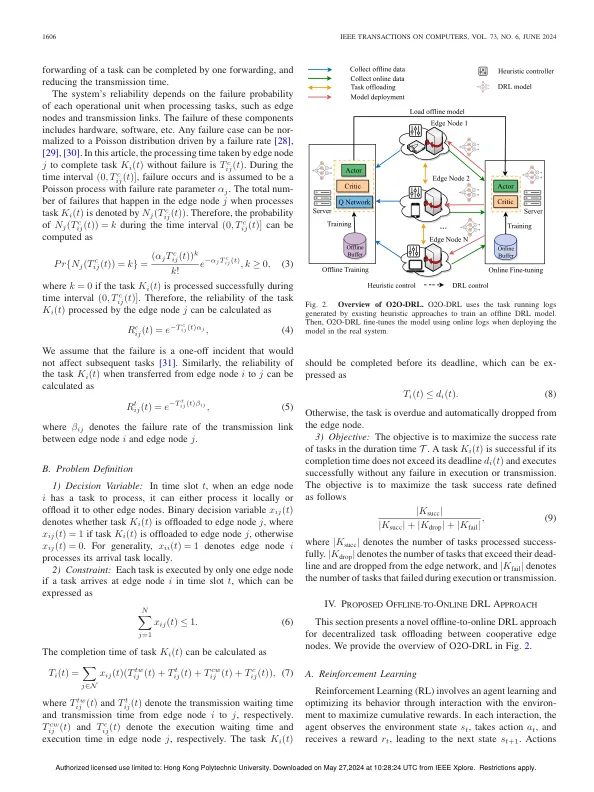

摘要 - 在合作边缘节点中流动的室内化任务已成为提高资源利用并改善边缘计算中用户的经验质量(QOE)的有前途的解决方案。但是,当前的分散方法(例如启发式方法和基于游戏理论的方法)可以优化贪婪或依赖于刚性假设,无法适应动态边缘环境。现有的基于DRL的方法在模拟中训练该模型,然后将其应用于实用系统。由于实际系统与模拟环境之间的差异,这些方法的性能可能很差。其他直接训练模型和部署模型的方法将面临一个冷启动的问题,这将在模型收敛之前减少用户的QOE。本文提出了一本名为(o2o-drl)的drl-on-Online DRL小说。它使用启发式任务日志来启动lim的DRL模型。但是,频道和在线数据具有不同的分布,因此,使用局部方法进行在线调整会破坏所学的局部策略。为了避免此问题,我们使用派利DRL来调整模型并防止价值高估。我们在模拟和基于Kubernetes的测试台中使用其他方法评估O2O-DRL。性能结果表明,O2O-DRL胜过其他方法,并解决了冷门问题。

分散任务在边缘计算中卸载

主要关键词