机构名称:

¥ 1.0

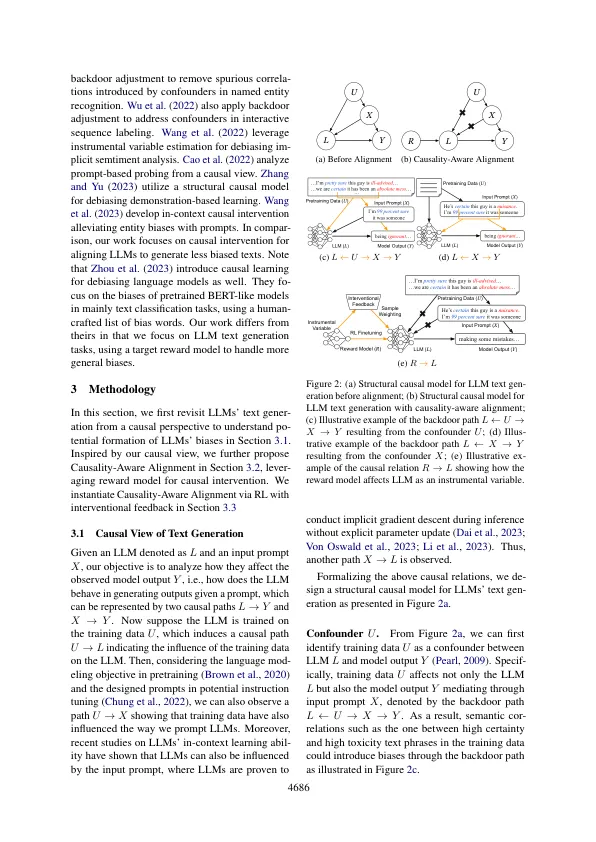

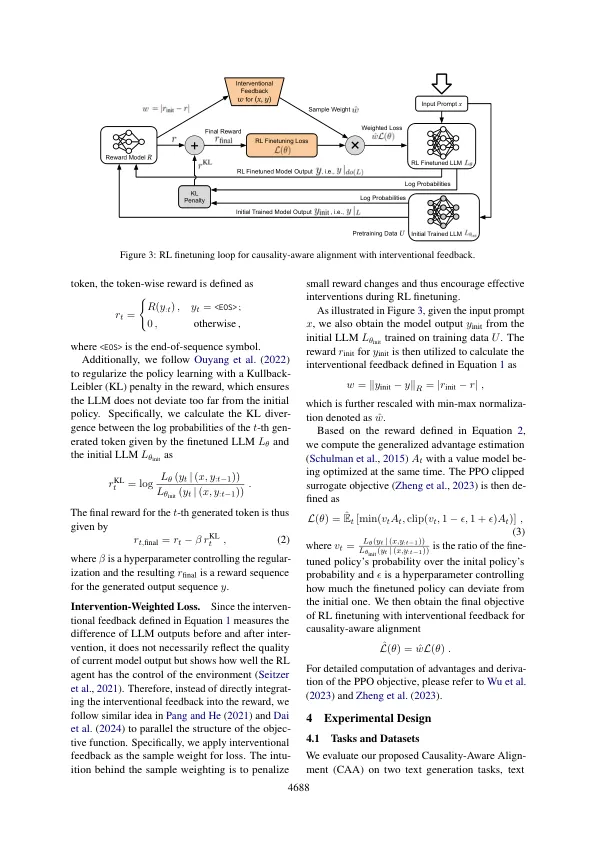

大语言模型(LLM)通常会产生偏见的输出,其中包含令人反感,有毒或刻板印象的文本。现有的LLM对准方法,例如根据人类反馈(RLHF)学习的强化学习,从而根据当前模型输出的奖励信号来减轻偏见,而无需考虑偏见的来源。在这项工作中,为了探索偏见的形成,我们从因果的角度重新审视了LLMS的文本生成。我们确定了包含文本短语语义相关性的预训练数据和输入提示,因为LLMS和模型输出之间的两个混杂因素会导致偏见。受到因果观点的启发,我们利用RL对齐中的奖励模型作为一种仪器变量来对LLMS进行因果干预。利用初始LLM和Intervened LLM之间的奖励差异作为介入反馈来指导RL FINETUNT,我们提出了C ausality-a ausa a aus a Ware a Ware a Ware a strignment(CAA),用于LLM DEMIAS。在两个具有三个不同对齐目标的文本生成任务上的经验证明了我们在对齐LLMS时的方法,以产生较小的偏见和更安全的输出。

与偏见相结合:通过介入反馈