机构名称:

¥ 1.0

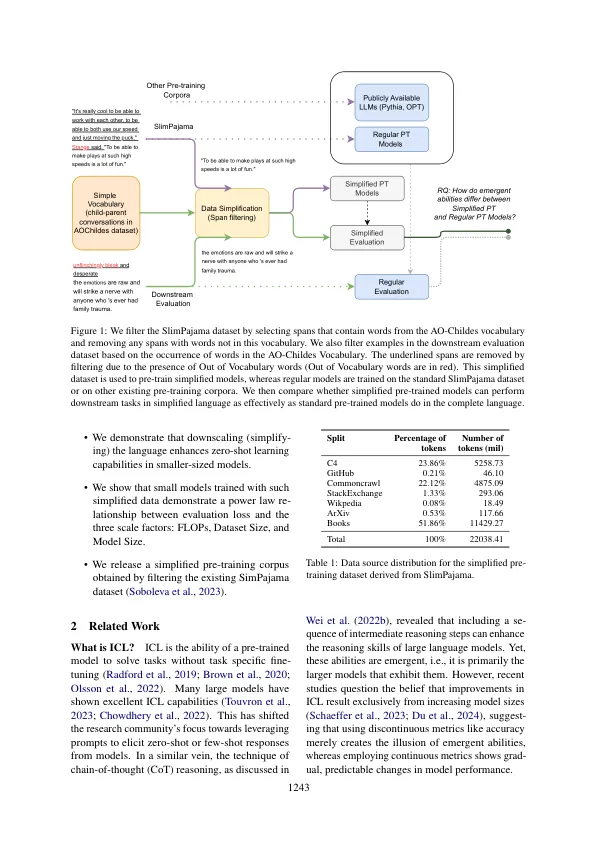

大型语言模型可以解决新任务,而无需特定于任务的微调。这种能力,也称为文化学习(ICL),具有出现的能力,主要是在具有数十亿个参数的大语言模型中看到的。这项研究研究了这种紧急特性是否严格与模型大小相关,或者可以通过较小的模型进行培训的较小尺度数据。为了探讨这一点,我们简化了训练前数据和训练前36个因果语言模型,参数从100万到1.65亿个参数不等。我们表明,在此简化的预训练数据上训练的模型表明,以简化语言的各种任务进行了增强的零射击功能,从而实现了在不受限制的语言上六倍的预训练模型的性能组合。这表明降低语言允许零击学习能力在大小有限的模型中出现。此外,我们发现这些较小的模型在简化的数据上进行了预训练,证明了评估损失与三个缩放因素之间的功率定律关系:计算,数据集大小和模型大小。1

降低的生成语言模型中的紧急能力