机构名称:

¥ 1.0

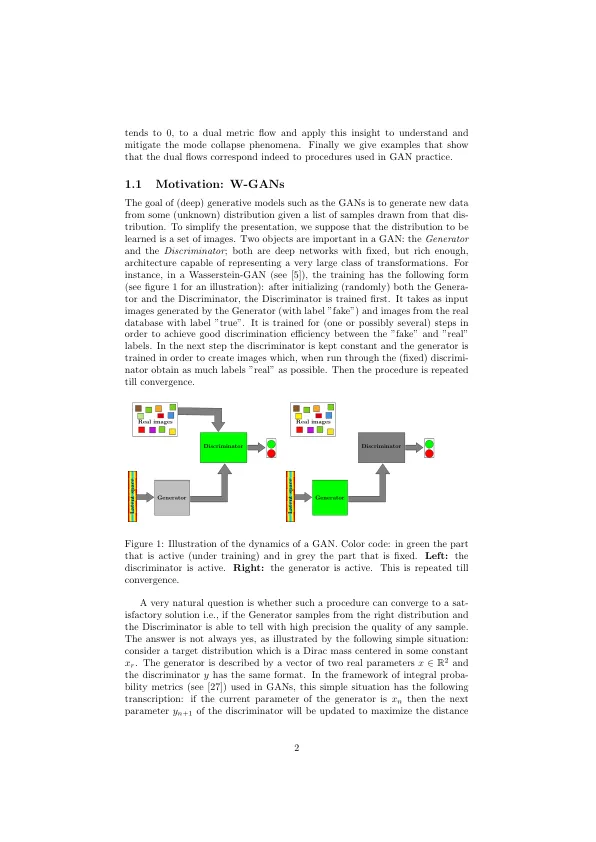

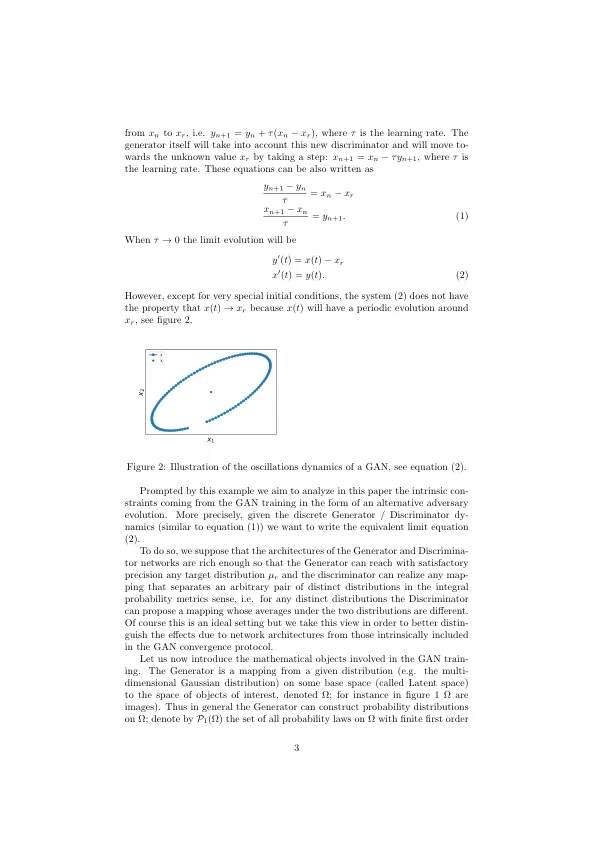

拟合神经网络通常求助于随机(或类似)的梯度下降,这是梯度下降动力学的耐噪声(且有效的)分辨率。它输出了一系列网络参数,这些参数在训练步骤中会演变。梯度下降是极限,当学习率较小并且批处理大小不限时,在训练过程中获得的这组越来越最佳的网络参数。在此贡献中,我们研究了机器学习中使用的生成对抗网络中的收敛性。我们研究了少量学习率的限制,并表明,与单个网络培训类似,GAN学习动力趋于消失学习率至一定的限制动态。这导致我们考虑度量空间中的进化方程(这是我们称为双流的自然框架)。我们给出了解决方案的正式定义,并证明了这种转化。该理论然后将其应用于甘斯的特定实例,我们讨论了这种见解如何有助于理解和减轻模式崩溃。关键字:gan;公制流;生成网络

生成对抗网络的收敛动力学

主要关键词