XiaoMi-AI文件搜索系统

World File Search SystemAI 可广泛应用于协同办公场景,利好龙头厂商

图 1 : AI 带来 OA 功能的重构 ......................................................................................... 3 图 2 :微软发布 Copilot .................................................................................................. 3 图 3 :百度“如流” ........................................................................................................ 3 图 4 : Copilot 根据要求起草邮件 .................................................................................... 4 图 5 : Copilot 提炼邮件内容 ........................................................................................... 4 图 6 : Copilot 对会议内容进行总结并支持提问 .............................................................. 5 图 7 : Copilot 支持会议内容的实时总结和提问 .............................................................. 5 图 8 : Copilot 对客户关注的领域进行扫描 ..................................................................... 5 图 9 : Copilot 根据销售资料提供竞品分析建议 .............................................................. 5 图 10 : Copilot 整理各类资料协作对工作内容进行梳理 ................................................. 6 图 11 : Copilot 为接下来的会议准备相关资料 ................................................................ 6 图 12 :泛微智能办公平台框架图 .................................................................................... 7 图 13 :泛微智能办公平台前端技术 ................................................................................ 7 图 14 :泛微小 e 助手查询业绩 ....................................................................................... 7 图 15 :泛微小 e 助手智能填单 ....................................................................................... 7 图 16 :小致语音助手技术框架 ........................................................................................ 8 图 17 :小致语音助手使用示例 ........................................................................................ 8

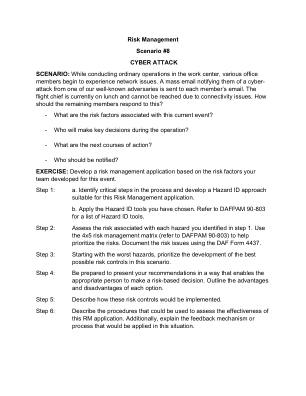

风险管理场景 #8 网络攻击场景

场景:在工作中心进行常规操作时,各办公室成员开始遇到网络问题。一封群发电子邮件通知他们来自我们知名对手之一的网络攻击,该邮件将发送到每个成员的电子邮箱。飞行队长目前正在吃午饭,由于连接问题无法联系到他。其余成员应如何应对?

录用稿件,非最终出版稿 - 工程科学学报

因此,跨个体、跨场景的脑电分析方法逐渐成为研究热点。越来越多的研究人员将广泛应用脑 电信号分析的特征于跨个体、跨场景的脑电信号分析研究中。 Touryan 等人采用经典的独立成分分 析的特征分析方法描述特征空间,计算功率谱密度( Power Spectral Density , PSD ),并采用顺序 前向浮动选择方法识别频谱特征中的独立成分集,结果表明该方法可以识别出跨场景脑电信号中的 共同成分 [88] 。 Kakkos 等人采用了特征融合的方法,将 PSD 与功能连接特征相结合,提高了跨场景 分类的性能,并证明了脑特征融合在跨场景中的应用更为有效 [89] 。 Xing 等人将模糊熵特征用于跨 场景脑电信号分析,发现模糊熵特征相对于其他特征更能适合跨场景 [90] 。卷积神经网络 ( Convolutional Neural Networks , CNN )和递归神经网络( Recurrent Neural Networks , RNN )等基 于深度学习的新型跨任务模型在跨场景脑电分析中展现了巨大潜力。这些模型能够自动提取特征和 学习复杂的脑电特征,从而有效地缩小不同任务和场景之间的差距,提高模型的泛化能力 [91][92][93] 。 近年来,一些跨学科的方法被创新性地应用于跨场景研究, Zhao 等人提出了一种跨学科的对齐多 源域自适应方法,用于跨个体的 EEG 疲劳状态评估,显著提高了模型的泛化能力 [94] , Zhou 等人在 此基础上进行改进,提出了一种跨任务域自适应方法,有效提升了跨场景认知诊断的性能 [95] 。

场景 - DVB

TR 102 768 Ver. 1.1.1 - 卫星分配系统的交互信道;移动场景中 EN 301 790 使用指南 (20/04/2009) TS 102 611-1 Ver. 1.2.1 - IP 数据广播:移动性实施指南;第 1 部分:DVB-H 上的 IP 数据广播 (29/04/2009) TS 102 611-2 Ver. 1.1.1 - IP 数据广播:移动性实施指南;第 2 部分:DVB-SH 上的 IP 数据广播 (29/04/2009) TS 102 471 Ver. 1.3.1 - DVB-H 上的 IP 数据广播:电子服务指南 (ESG) (24/04/2009) TS 102 770 Ver. 1.1.1 - DVB 系统中的系统可更新性消息(SRM)(2009/05/12)EN 301 790 Ver. 1.5.1 - 卫星分发系统的交互信道(2009/05/13)TR 102 679 Ver. 1.1.1 - DVB URN 和分类方案注册表(2009/05/13)TS 102 472 Ver. 1.3.1 - DVB-H 上的 IP 数据广播:内容传送协议(2009/06/09)TR 102 377 Ver. 1.4.1 - DVB-H 实施指南(2009/06/16)TS 102 771 Ver. 1.1.1- 通用流封装 (GSE) 实施指南 (2009/06/16) TS 102 591 Ver. 1.2.1 - DVB-H 上的 IP 数据广播:内容传送协议 (CDP) 实施指南 (2009/06/25) TR 101 211 Ver. 1.9.1 - 服务信息 (SI) 实施和使用指南 (2009/06/26) TS 101 162 Ver. 1.2.1 - DVB 系统的服务信息 (SI) 和数据广播代码分配 (2009/07/01)

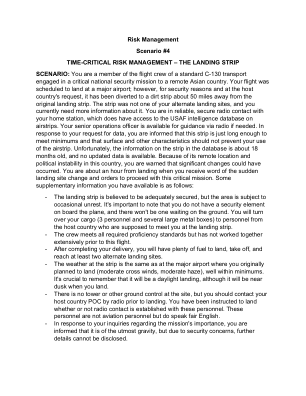

风险管理场景#4

场景:您是标准 C-130 运输机的机组人员,正在执行一项重要的国家安全任务,前往一个偏远的亚洲国家。您的航班原定降落在一个主要机场;但是,出于安全原因和应东道国的要求,航班已转移到距离原着陆跑道约 50 英里的一条土跑道上。这条跑道不是您的备用着陆点之一,您目前需要有关它的更多信息。您与您的主站保持可靠、安全的无线电联系,主站可以访问有关飞机跑道的美国空军情报数据库。如果需要,您的高级作战官可以通过无线电提供指导。在回复您的数据请求时,您被告知这条跑道的长度刚好满足最低要求,并且表面和其他特征不会妨碍您使用该飞机跑道。不幸的是,数据库中有关该跑道的信息已有大约 18 个月的历史,并且没有更新的数据。由于该跑道位置偏远且该国政治不稳定,您被警告可能发生重大变化。距离着陆还有大约一小时,您就收到着陆地点突然变更的消息,并接到命令继续执行这一关键任务。您可以获得的一些补充信息如下:

案例场景1

案例场景3医师办公室报告 - 1/3/11一名47岁的女性伴随着她的左乳房的变化。她于2005年2月被诊断出患有左乳房的导管癌。当时,她接受了乳房保存手术的乳房淋巴结清扫术,显示了21个阳性淋巴结中的3个。她接受了化学疗法和放射线。她最近向我的办公室介绍了她的左乳房已经肿胀,触摸温暖,皮肤的区域变稠和粉红色。体格检查显示乳房的水肿和橙色外观。还指出,她乳房下部的下部是一个明显的肿块。进行了立体定向的针头活检,发现她具有侵入性导管癌,ER和PR阳性,HER2/NEU 3+(阳性)由IHC。她被转介给肿瘤科医生进行治疗计划。肿瘤学咨询/评估和计划 - 1/12/11一名先前具有导管癌病史的患者现在出现炎症性乳腺癌,涉及她的乳房一半。完整的分期检查显示左乳房有4.8厘米的肿瘤。似乎没有直接入侵皮肤或胸壁。注意到,先前已除去腋窝淋巴结。未发现转移。但是,对循环肿瘤细胞进行的IMS测试呈阳性。这将是我的计划,以术前化学疗法相对迅速地治疗她。如果她对化学疗法有反应,则将进行乳房切除术和其他化疗。由于以前的辐射,她不是额外辐射处理的候选者。进度注释-11/21/11患者接受了为期9周的邻苯二甲酸,紫杉烷和曲妥珠单抗的术前课程。她对治疗有很好的部分反应。她计划进行简单的乳房切除术,并于本周晚些时候插入组织扩张器。简单乳房切除术-2/28/11最终病理报告

场景比较

本报告受益于众多专家的评论和评论,包括威廉·齐默恩(BP),克里斯托夫·乔格尔(Christoph Jugel)(德国能源局[DENA]),Mathias Kimmel(Bloombergnef [bnef]),Sheila Samsatli,Sheila Samsatli(Bath [UOB]),Trieu Mai(Trieu Mai(Natire renewable Energution University Munor Encorlation Munor Encortor unohi Munohi Mun an nich an) [TUM]), Christof van Agt (International Energy Forum [IEF]), Edward Byers (International Institute for Applied Systems Analysis [IIASA]), Jürgen Kropp (Potsdam Institute for Climate Impact Research [PIK]), Andries Hof (Netherlands Environmental Assessment Agency [PBL]), James Newcomb (Rocky Mountain Institute [RMI]), Anastasia Belostotskaya (World Energy Council [WEC])和Daniel Raimi(未来资源[RFF])。我们还要感谢Ioannis Tsiropoulos,他一开始就帮助塑造了研讨会。