机构名称:

¥ 1.0

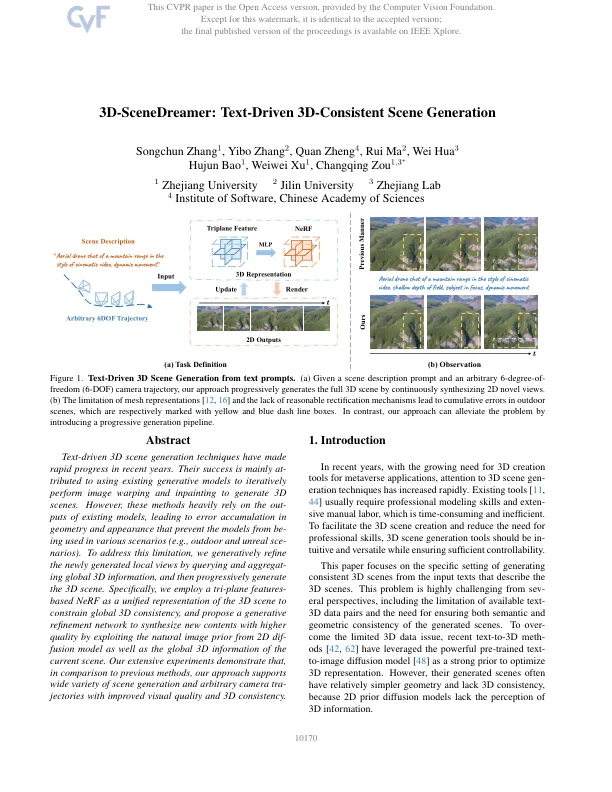

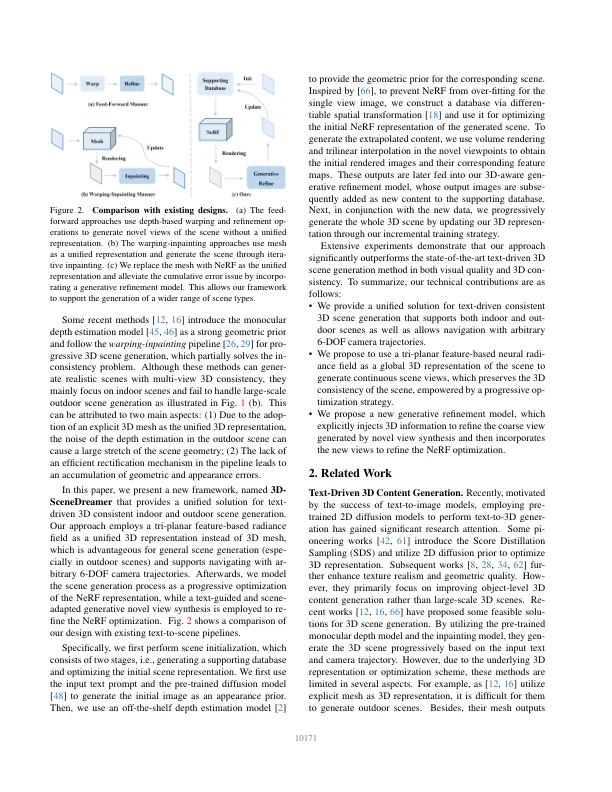

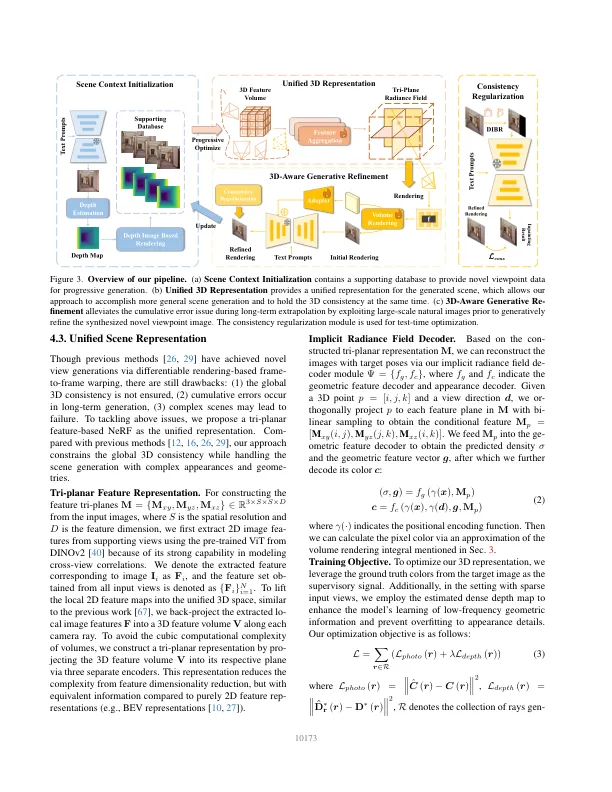

文本驱动的3D场景生成技术近年来取得了迅速的进步。他们的成功主要是为了使用现有的生成模型进行迭代执行图像翘曲和介入以生成3D场景。但是,这些方法在很大程度上依赖于现有模型的外部,从而导致几何和外观中的错误积累,从而阻止模型在各种情况下使用(例如,户外和虚幻的SCE-Narios)。为了解决此限制,我们通常通过查询和聚集全局3D信息来完善新生成的本地视图,然后逐步生成3D场景。具体而言,我们采用基于三平面特征的NERF作为3D场景的统一表示,以限制全局3D的一致性,并提出一个生成的改进网络,通过从2D差异模型以及当前场景的全球3D信息中利用自然图像来综合具有更高质量的新内容。我们的广泛实验表明,与以前的方法相比,我们的方法支持各种各样的场景产生和任意相机传播,并具有提高的视觉质量和3D一致性。

文本驱动的3D一致场景发电