机构名称:

¥ 2.0

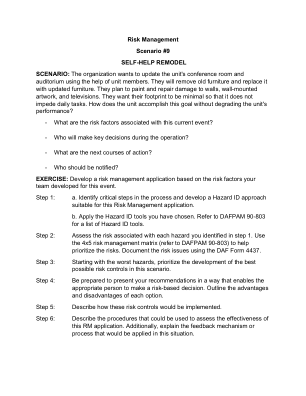

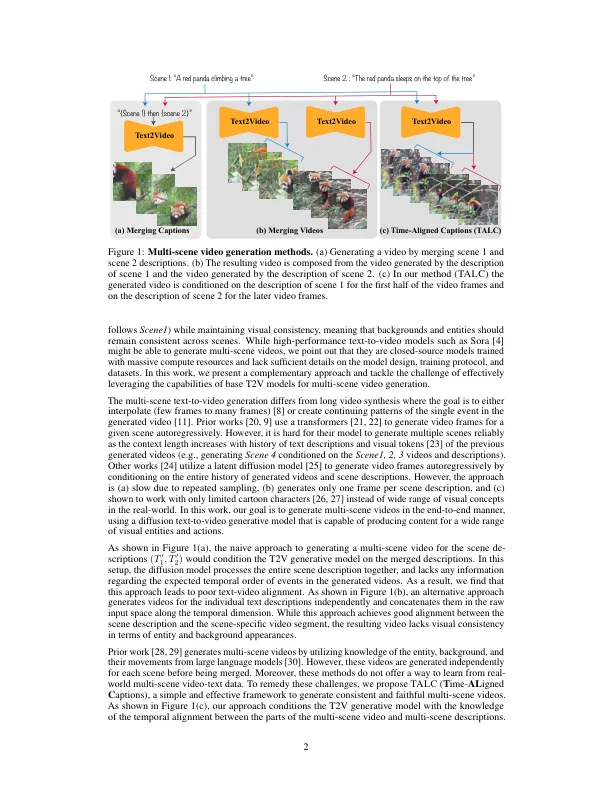

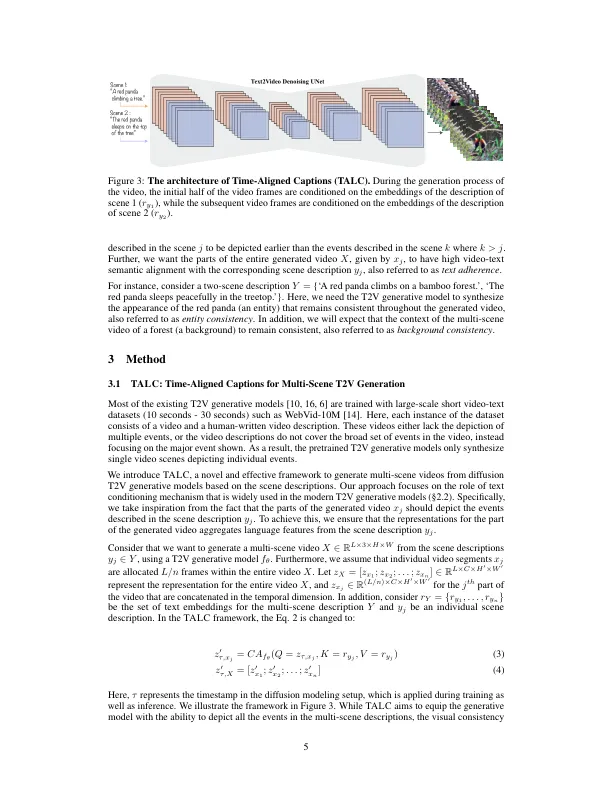

基于扩散的生成建模的最新进展导致了文本对视频(T2V)模型的开发,这些模型可以在文本提示下生成高质量的视频。这些T2V模型中的大多数通常会产生单场视频剪辑,该视频片段描绘了执行特定动作的实体(例如,“红熊猫爬树”)。但是,由于它们在现实世界中无处不在(例如,“红色熊猫爬树”,然后是“红熊猫睡在树的顶部”)。要从验证的T2V模型中生成多场景视频,我们介绍了IME IGNED C APTIONS(TALC)框架。具体来说,我们增强了T2V体系结构中的文本调节机制,以识别视频场景和场景描述之间的时间对齐。例如,我们调节生成视频的早期和后期场景的视觉特征,其中包括第一个场景描述的表示(例如,“红色熊猫爬树”)和第二个场景描述(例如,“红色熊猫睡在树的顶部”)。因此,我们表明T2V模型可以生成遵守多场曲线文本描述并在视觉上保持一致的多场景视频(例如,实体和背景)。,我们使用TALC框架使用多场景视频文本数据进行预验证的T2V模型。我们表明,滑石粉模型的表现优于基线方法,总分中的基线方法平均使用人类评估来平均视觉一致性和文本依从性。项目网站是https://talc-mst2v.github.io/。

滑石:多场景文本到...

![[2]高棉的文本图像重建和赔偿...](/simg/1/1436b766064e02f32511275e22f481abc7f51e52.webp)