机构名称:

¥ 1.0

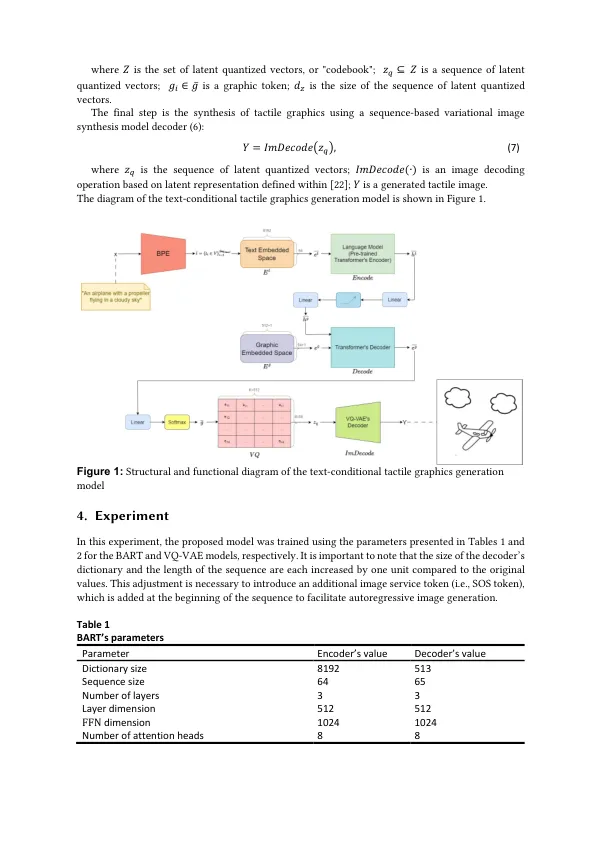

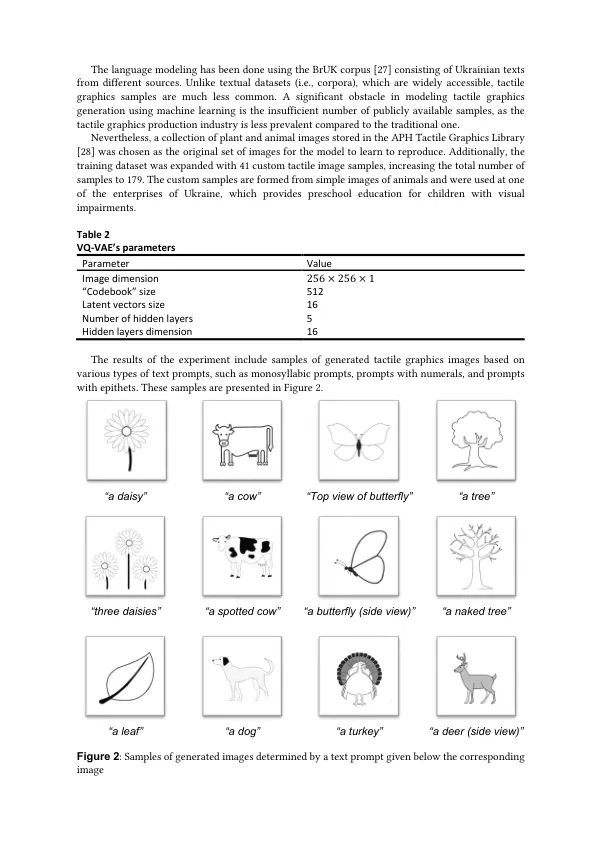

摘要本研究介绍了使用双向和自动回归变压器(BART)和向量量化的变分自动编码器(VQ-VAE)的文本条件触觉图形生成模型的开发。该模型利用了潜在空间的修改组织,分为两个独立的组件:文本和图形。该研究通过使用自定义样本扩展培训数据集来解决触觉图形样本有限的挑战,从而增强了模型将文本信息转换为图形表示的能力。提出的方法改善了视障人士的触觉图形创建,从而在合成的触觉图形中提供了增加的可变性,可控性和质量。这一进步增强了包容性教育材料生产过程的技术和经济方面。

人工智能驱动的视觉受损的人驱动的文本到触觉图形生成

主要关键词