XiaoMi-AI文件搜索系统

World File Search System2025 USDA解释性注释

阿菲斯(Aphis)及其利益相关者保护动物和植物资源的健康,以确保为美国客户提供丰富的农产品和服务,并促进其在全球市场的运动,以使农村社区和所有美国人受益。作为这项任务的一部分,Aphis确保生物技术衍生的农产品不会无意间引入植物有害生物或疾病,并可以为美国农民提供增强世界食品和纤维的生产。Aphis警卫反对引入或重新出现动物和植物害虫和疾病,这些疾病和疾病可能会限制农业生产和损害出口市场。同时,阿菲斯(Aphis)监测并应对农业生物恐怖,入侵物种,野生动植物和牲畜疾病的潜在行为以及人类与野生动植物之间的冲突。该机构有助于解决卫生(动物)和植物检疫(植物)贸易壁垒,并执行与某些动物人道治疗有关的联邦法律。最后,阿菲斯(Aphis)在《联邦一人健康计划》中发挥了重要作用,有助于检测和防止人畜共患病的传播,这些疾病威胁着从动物转移到人类。

在人工智能驱动的 SCM 项目中架起可解释性和可解释性的桥梁,以增强决策能力

因此,可解释性被提出作为增强基于人工智能的系统可理解性的替代概念。与可解释性的区别在于“可解释模型是学习更结构化、可解释或因果模型的机器学习技术”[4]。换句话说,简单地说,可以说可解释性回答了“人工智能模型是如何工作的?”的问题,而可解释性则侧重于“为什么人工智能模型会提出这样的决定?”。许多作者都做出了这种区分[8-9],尽管其他一些人以不加区分的方式使用“可解释性”和“可解释性”这两个术语[10-13],或者最终坚持可解释模型的卓越性,特别是如果自动决策算法影响人类[14-15]。这种缺乏共识至少在一定程度上是由于解决可解释性问题的领域的异质性。然而,这些关键概念的定义对于研究项目的构建和推进至关重要。这就是为什么我们提出探索这样一个假设,即管理可解释性和可解释性之间的协同作用可以对决策过程产生积极影响,我们为此目的进行系统的文献综述。

人工智能决策中的公平性和解释性

摘要:影响个人的人工智能辅助决策提出了关于人工智能透明度和公平性的关键问题。许多研究强调了人工智能辅助决策中透明度/解释和公平性之间的相互关系。因此,同时考虑它们对用户信任或感知公平性的影响有利于负责任地使用社会技术人工智能系统,但目前很少受到关注。在本文中,我们分别研究了人工智能解释和公平性在特定基于人工智能的决策场景中对人类-人工智能信任和感知公平性的影响。一项模拟人工智能辅助决策在两个健康保险和医疗决策场景中的用户研究提供了重要的见解。由于全球大流行及其限制,用户研究以在线调查的形式进行。从参与者的信任角度来看,公平性仅在公平性水平较低的情况下才会影响用户信任,而公平性水平较低会降低用户信任。然而,增加解释有助于用户增加对人工智能辅助决策的信任。从感知公平的角度来看,我们的研究发现,引入低水平的公平性会降低用户的公平性感知,而引入高水平的公平性会提高用户的公平性感知。解释的加入无疑会增加公平性感知。此外,我们发现应用场景会影响信任和公平性感知。结果表明,在人工智能应用中使用人工智能解释和公平性陈述是复杂的:我们不仅需要考虑引入的解释类型和公平性程度,还需要考虑人工智能辅助决策的使用场景。

超越可解释性的 AI 可解释性要求

摘要 随着人工智能 (AI) 在社会中的兴起,越来越多的人开始在日常生活中接触复杂且不透明的软件系统。这些黑盒系统通常难以理解,因此对最终用户来说并不可信。可解释人工智能 (XAI) 的研究表明,解释有可能解决这种不透明性问题,使系统更加透明和易于理解。然而,可解释性和可解释性之间的界限充其量是模糊的。虽然 XAI 中对可解释性有许多定义,但大多数定义都没有超越输出的合理性,即提供可解释性。与此同时,XAI 之外的当代研究已经采用了更广泛的可解释性定义,并研究了除算法及其输出之外的系统方面。在本立场文件中,我们认为 AI 系统的需求工程师需要考虑可解释性以外的可解释性要求。为此,我们提出了一个医疗领域的假设场景,该场景展示了 XAI 研究人员通常不会考虑的各种不同的可解释性要求。这篇文章旨在在 XAI 社区中引发讨论,并激励 AI 工程师在提出可解释性要求时跳出黑匣子。

灵活且针对具体情境的 AI 可解释性

摘要 近年来人们对人工智能 (AI) 的热情主要归功于深度学习的进步。深度学习方法非常准确,但也不太透明,这限制了它们在安全关键型应用中的潜在应用。为了获得信任和问责,机器学习算法的设计者和操作者必须能够向用户、监管者和公民解释算法的内部工作原理、结果以及失败的原因。本文的独创性在于结合可解释性的技术、法律和经济方面,开发一个框架来定义给定环境下可解释性的“正确”水平。我们提出了三个逻辑步骤:首先,定义主要的背景因素,例如解释的受众是谁、操作背景、系统可能造成的危害程度以及法律/监管框架。此步骤将有助于描述解释的操作和法律需求,以及相应的社会效益。第二步,检查可用的技术工具,包括事后方法(输入扰动、显著性图……)和混合 AI 方法。第三步,根据前两个步骤,选择正确的全局和局部解释输出级别,同时考虑所涉及的成本。我们确定了七种成本,并强调只有当总社会效益超过成本时,解释才具有社会意义。

关于...关税条例草案的解释性备忘录

(4)配电许可证持有者应在相应季度结束后的三十天内向委员会提交季度报告,报告内容应包括配电许可证持有者在相关季度向州政府提出的补贴要求的详细信息,该要求基于州政府宣布的补贴类别和消费者类别的每单位补贴的能源消耗情况、根据该法第 65 条实际支付的补贴、应付和已付补贴的缺口以及委员会和/或电力部根据《2003 年电力法》的规定制定的规则可能指定的其他相关细节。如果不遵守规定,委员会可以指示许可证持有者对许可证持有者的有关官员采取适当的行动。

在解释性和隐私之间进行权衡

摘要:随着AI的发展,了解复杂的AI决策背后的基本原理变得越来越重要。解释AI技术在揭开这些决策的神秘面前至关重要,提供了解释和传达AI驱动结果背后推理的方法和工具。然而,可解释的AI的兴起与保护敏感数据的必要性并列,从而导致加密技术在AI开发中的整合。本文探讨了AI中解释性和加密的复杂共存,呈现出一个困境,在这种困境中,寻求透明度与确保敏感信息的势在必行。矛盾在诸如同形加密之类的方法中尤为明显,在确保数据安全性的同时,它使为AI决策提供了清晰可解释的解释。讨论深入研究了这些方法的矛盾目标,调查了在Exable AI中使用隐私的方法的使用,并确定了未来研究的潜在方向。的贡献包括对当前可解释的AI方法中隐私注意事项的全面调查,一种模范用例,展示了可视化技术,可在安全环境中进行解释,并确定未来工作的途径。

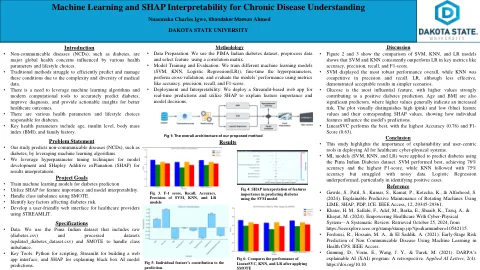

机器学习和对慢性疾病理解的可解释性

讨论•图2和3显示了SVM,KNN和LR模型的比较,表明SVM和KNN在准确性,精度,召回和F1得分等关键指标中的表现始终优于LR。•SVM总体上表现出最强大的性能,而KNN的精确性和召回率具有竞争力。lr虽然效率较低,但在更简单的情况下表现出了可接受的结果。•葡萄糖是最具影响力的特征,较高的值强烈促进阳性糖尿病预测。年龄和BMI也是重要的预测因子,其中较高的值通常表明风险增加。该图在视觉上区分高(粉红色)和低(蓝色)特征值及其相应的形状值,显示了单个特征如何影响模型的预测。•LinearSVC的表现最高,精度最高(0.76)和F1-SCORE(0.63)。

牙医 Covid 疫苗解释性声明

• 完成适当的教育和培训以接种疫苗; • 完成疾病预防控制中心疫苗在线培训; • 遵守华盛顿州 COVID-19 疫苗接种计划; • 接种疫苗前,请查看免疫登记处中患者的疫苗接种史; • 确保与患者沟通以获得知情同意; • 确保安全运输和储存,包括特殊冷藏需求(如有); • 考虑罕见的不良反应、识别和转诊; • 报告不良反应; • 考虑病史的特殊部分; • 确保与公共卫生部门就疫苗接种记录进行沟通; • 遵守第二剂、可能第三剂的通知协议; • 维护疫苗库存并安全处置未使用的库存; • 沟通并考虑常见的副作用和管理和/或转诊;以及 • 遵守所有联邦和州的报告要求。COVID-19 疫苗接种培训资源: