机构名称:

¥ 1.0

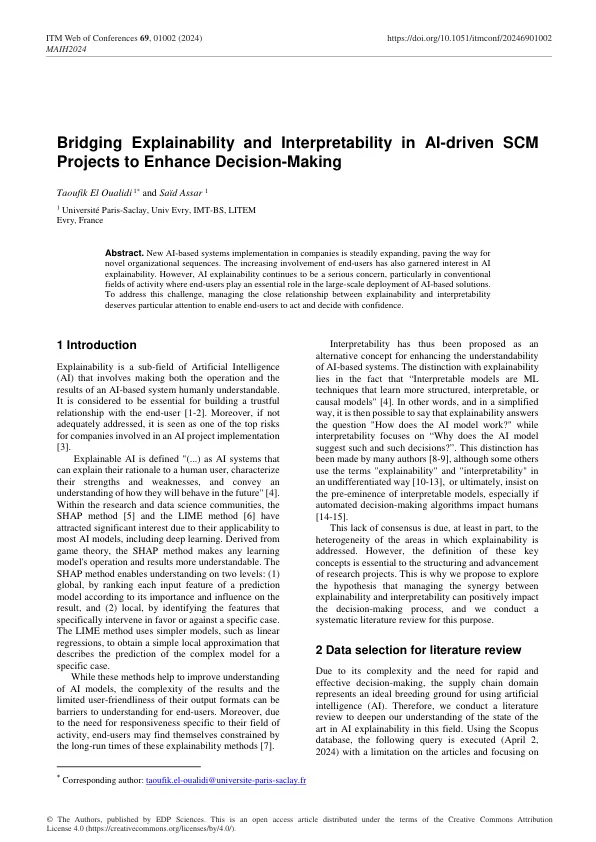

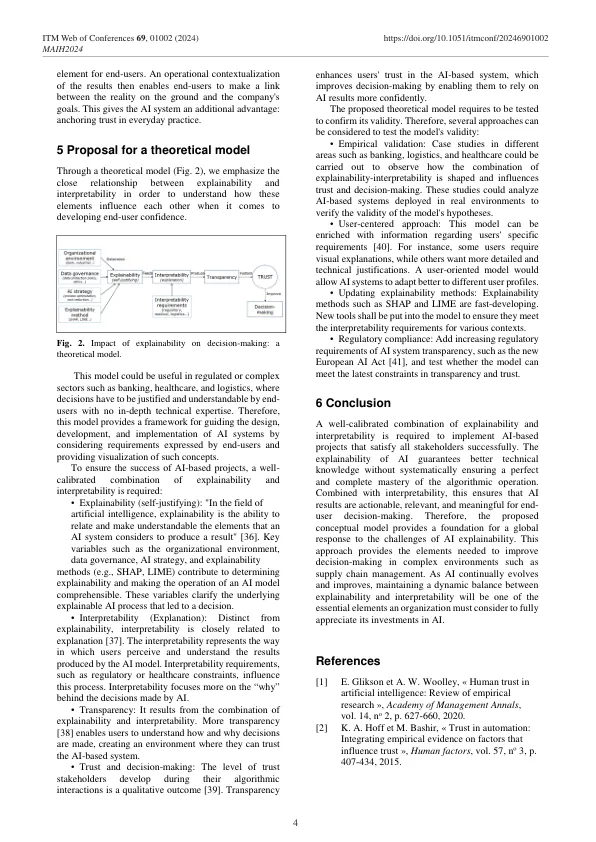

因此,可解释性被提出作为增强基于人工智能的系统可理解性的替代概念。与可解释性的区别在于“可解释模型是学习更结构化、可解释或因果模型的机器学习技术”[4]。换句话说,简单地说,可以说可解释性回答了“人工智能模型是如何工作的?”的问题,而可解释性则侧重于“为什么人工智能模型会提出这样的决定?”。许多作者都做出了这种区分[8-9],尽管其他一些人以不加区分的方式使用“可解释性”和“可解释性”这两个术语[10-13],或者最终坚持可解释模型的卓越性,特别是如果自动决策算法影响人类[14-15]。这种缺乏共识至少在一定程度上是由于解决可解释性问题的领域的异质性。然而,这些关键概念的定义对于研究项目的构建和推进至关重要。这就是为什么我们提出探索这样一个假设,即管理可解释性和可解释性之间的协同作用可以对决策过程产生积极影响,我们为此目的进行系统的文献综述。

在人工智能驱动的 SCM 项目中架起可解释性和可解释性的桥梁,以增强决策能力