机构名称:

¥ 1.0

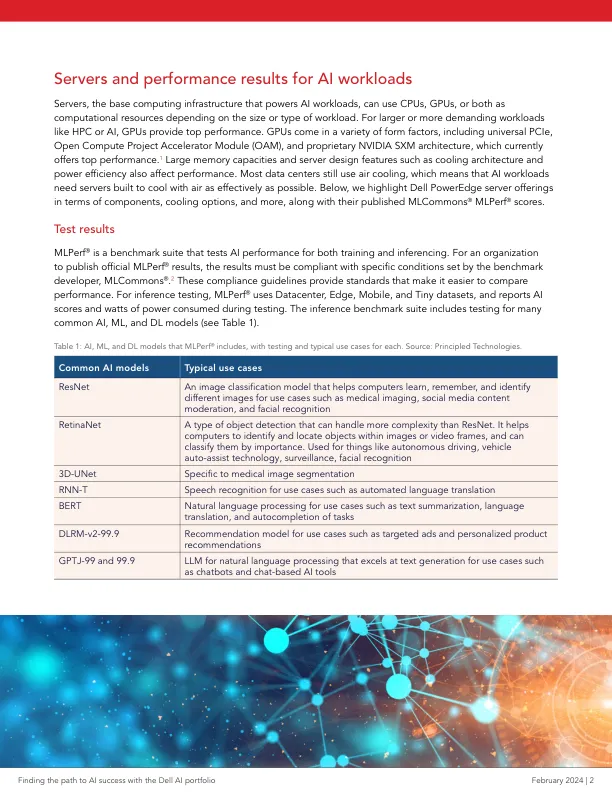

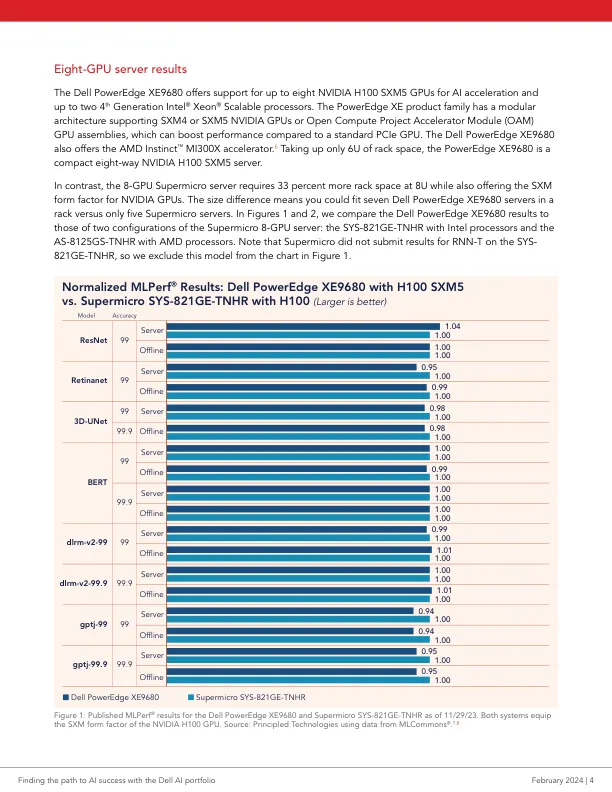

服务器是支持 AI 工作负载的基础计算基础设施,它可以根据工作负载的大小或类型使用 CPU、GPU 或两者作为计算资源。对于 HPC 或 AI 等更大或要求更高的工作负载,GPU 可提供最佳性能。GPU 具有多种外形尺寸,包括通用 PCIe、开放计算项目加速器模块 (OAM) 和专有的 NVIDIA SXM 架构,后者目前可提供最佳性能。1 大内存容量和服务器设计功能(例如冷却架构和功率效率)也会影响性能。大多数数据中心仍使用空气冷却,这意味着 AI 工作负载需要尽可能有效地用空气冷却的服务器。下面,我们将重点介绍 Dell PowerEdge 服务器产品的组件、冷却选项等,以及它们发布的 MLCommons ® MLPerf ® 分数。

AI 产品组合与 Supermicro 对比

主要关键词