机构名称:

¥ 1.0

模型能够有效地处理它,尽管没有人完全理解如何 • 它可能以大量权重 / 参数为代价,这些权重 / 参数可以看作是对不同表示之间关联强度的编码 [据传,GPT-4 有 1.76 万亿个参数];所有这些参数以及一个大的上下文窗口可能提供一种从输入本身有效推断 / 获取相关上下文的方法 • 如此密集的计算复杂性可以看作反映了 Nicholas Shea [2024] 所说的 If-Then 问题,或 CR Gallistel 所说的可能的无限性 [Gallistel and King 2010]:也许只是框架问题的一种变体?

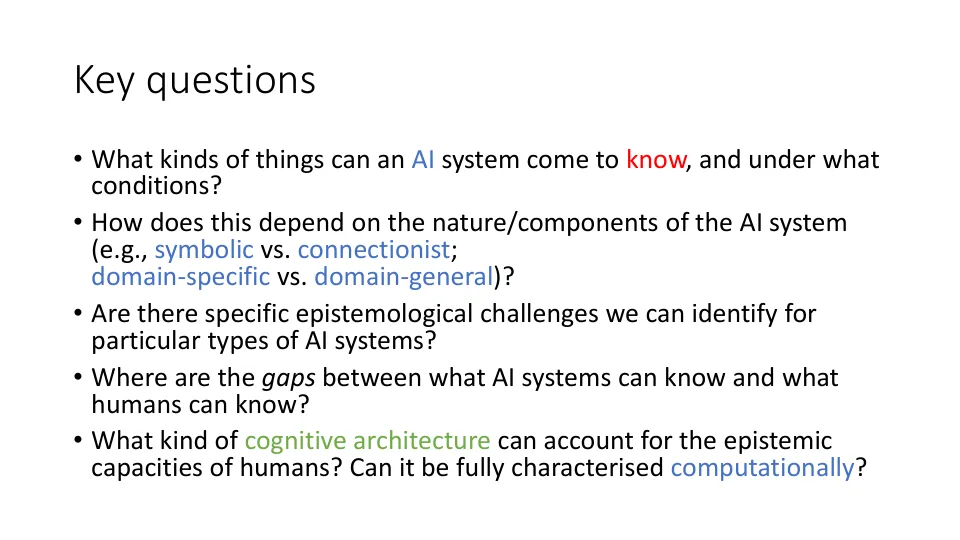

人工智能的认识论