机构名称:

¥ 1.0

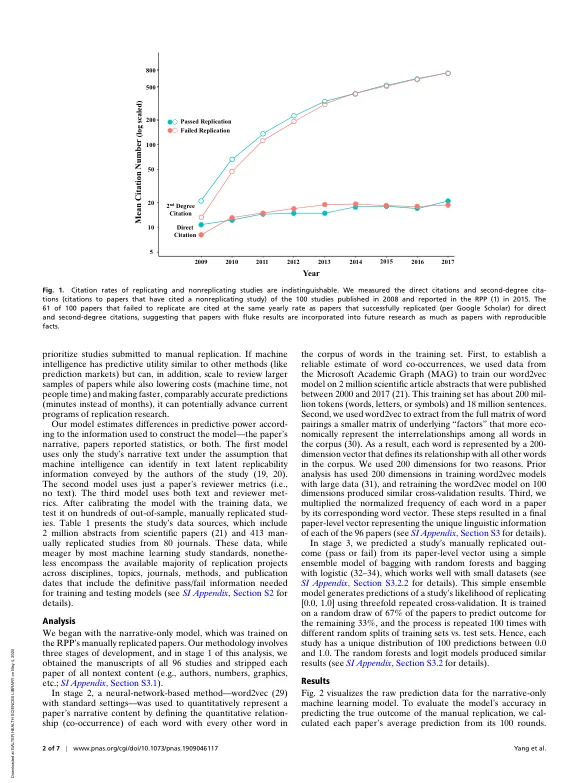

科学论文的可重复性测试表明,大多数论文都无法重复。此外,失败的论文在文献中的传播速度与可重复的论文一样快。这种动态削弱了文献,增加了研究成本,并表明需要新的方法来评估研究的可重复性。在这里,我们训练了一个人工智能模型,使用通过或未通过手动复制测试的研究的基本事实数据来评估论文的可重复性,然后在大量样本外研究中测试该模型的普遍性。该模型对可重复性的预测优于审稿人的基本比率,并且与预测市场相当,这是当今预测可重复性的最佳方法。在对来自不同学科和方法的手动复制论文进行样本外测试时,该模型的准确率高达 0.65 到 0.78。探索模型预测背后的原因,我们发现没有证据表明存在基于主题、期刊、学科、基准失败率、说服性词语或“非凡”或“出乎意料”等新颖词语的偏见。我们确实发现,当对论文文本而不是其报告的统计数据进行训练时,该模型的准确率更高,并且 n-gram(人类难以处理的高阶词组合)与复制相关。我们讨论如何将人类和机器智能结合起来,提高研究信心,提供研究自我评估技术,并创建可扩展且高效的方法来审查不断增长的出版物数量——这项任务需要大量人力资源,仅靠预测市场和手动复制才能完成。

使用... 评估科学发现的深度可重复性