机构名称:

¥ 1.0

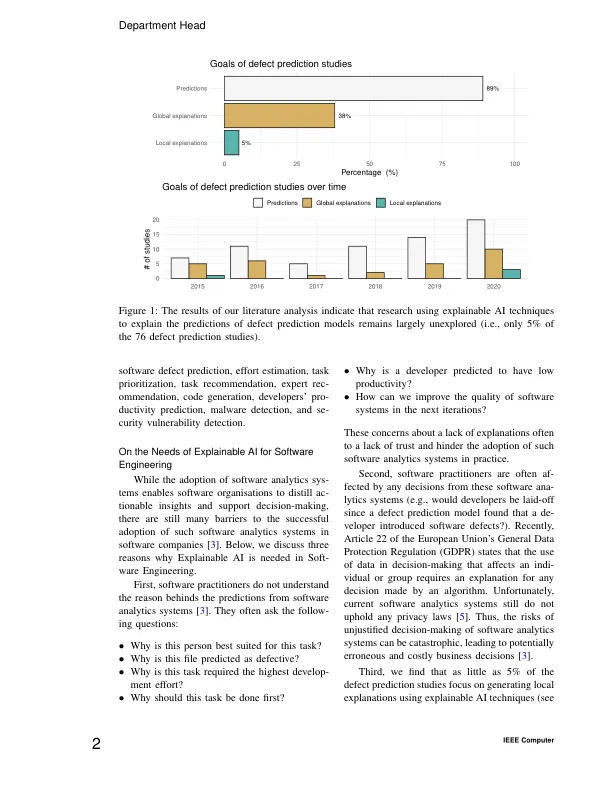

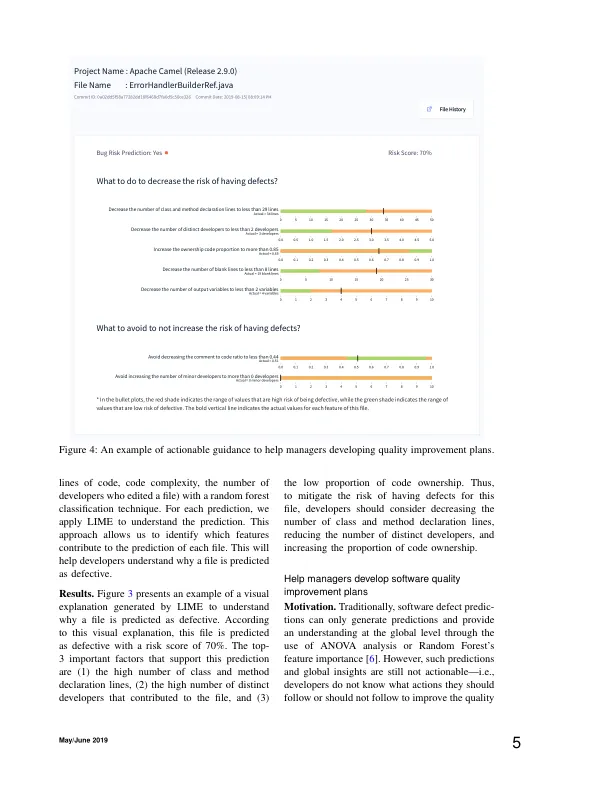

这些对缺乏解释的担忧往往导致缺乏信任,并阻碍了此类软件分析系统在实践中的采用。其次,软件从业者经常会受到这些软件分析系统做出的任何决策的影响(例如,由于缺陷预测模型发现开发人员引入了软件缺陷,开发人员会被解雇吗?)。最近,欧盟《通用数据保护条例》(GDPR)第 22 条规定,在影响个人或团体的决策中使用数据需要对算法做出的任何决策进行解释。不幸的是,当前的软件分析系统仍然不支持任何隐私法 [5]。因此,软件分析系统不合理决策的风险可能是灾难性的,导致潜在的错误和代价高昂的业务决策 [3]。第三,我们发现只有 5% 的缺陷预测研究专注于使用可解释的 AI 技术生成局部解释(参见

软件工程的可解释 AI