机构名称:

¥ 1.0

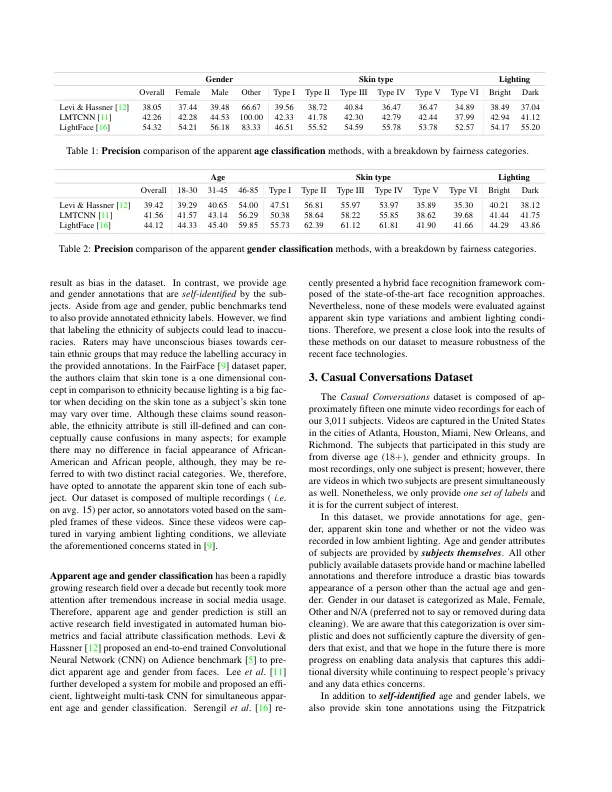

本文介绍了一种新颖的“公平性”数据集,以衡量 AI 模型对不同年龄、性别、表观肤色和环境光照条件的稳健性。我们的数据集由 3,011 名受试者组成,包含 45,000 多个视频,平均每人 15 个视频。这些视频是在美国多个州录制的,参与者是不同年龄、性别和表观肤色组的成年人。一个关键特征是每个受试者都同意参与并使用他们的肖像。此外,我们的年龄和性别注释由受试者自己提供。一组训练有素的注释者使用 Fitzpatrick 皮肤类型量表标记受试者的表观肤色 [ 6 ]。此外,还提供了在低环境光下录制的视频的注释。作为衡量跨某些属性的预测稳健性的应用,我们评估了最先进的表观年龄和性别分类方法。我们的实验从公平对待来自不同背景的人的角度对这些模型进行了彻底的分析。

随意对话:用于衡量公平性的数据集......