机构名称:

¥ 1.0

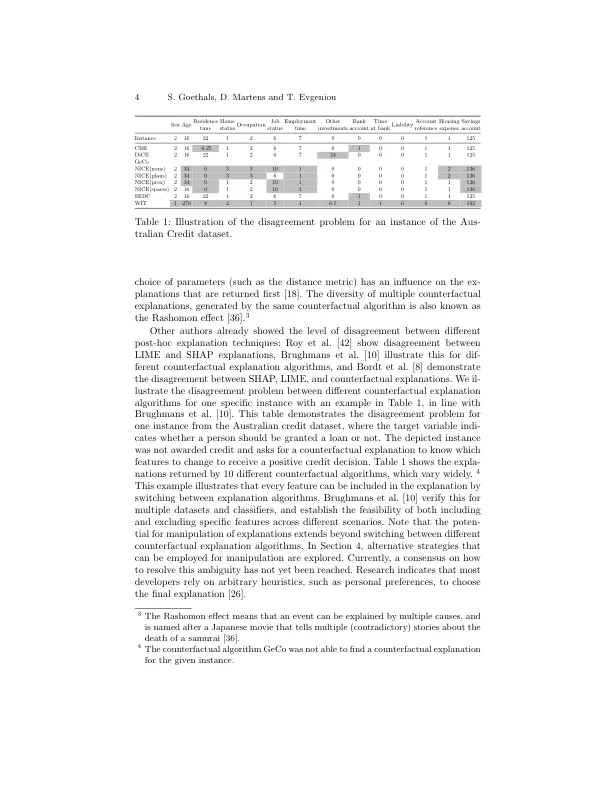

摘要。人工智能 (AI) 系统越来越多地应用于我们生活中的高风险领域,这增加了对这些决策进行解释并确保它们与我们希望做出的决策方式相一致的必要性。可解释人工智能 (XAI) 领域应运而生。然而,它面临着一个重大挑战,即分歧问题,即对于同一个人工智能决策或预测可能有多种解释。虽然分歧问题的存在已被承认,但与此问题相关的潜在影响尚未得到广泛研究。首先,我们概述了解释提供者可以部署的不同策略,以使返回的解释适应他们的利益。我们区分了攻击机器学习模型或底层数据以影响解释的策略,以及直接利用解释阶段的策略。接下来,我们分析了提供者可能参与这种行为的几个目标和具体场景,以及这种操纵行为可能对社会造成的潜在危险后果。我们强调,在这些方法被广泛实施之前,研究这个问题至关重要,并提出一些缓解策略。

可解释人工智能中的操纵风险:分歧问题的影响