机构名称:

¥ 1.0

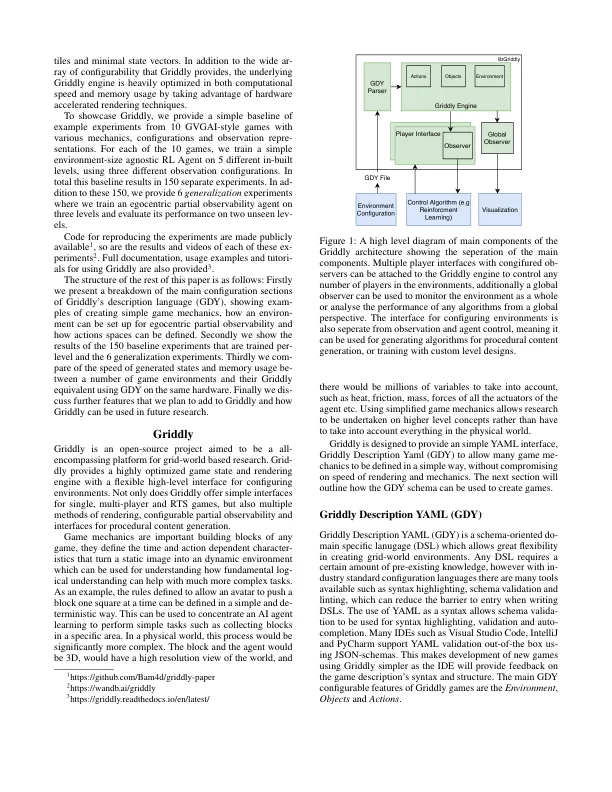

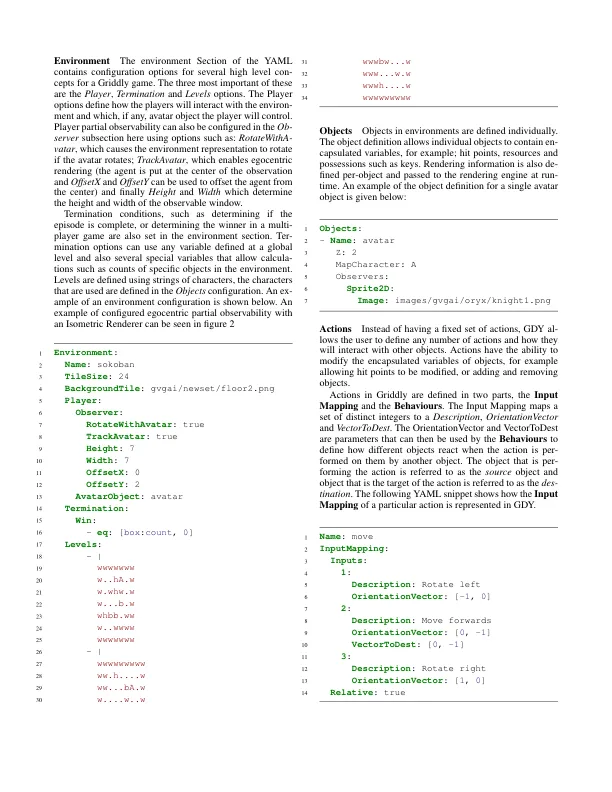

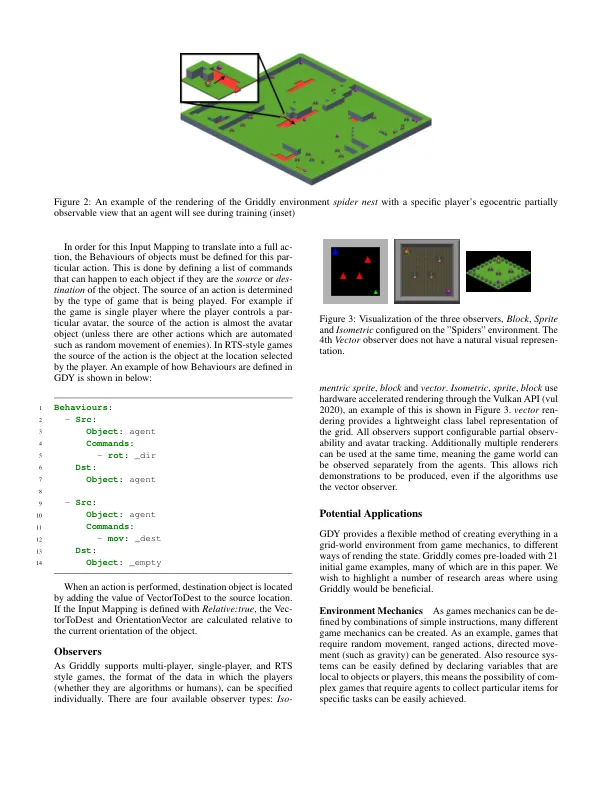

近年来,游戏 AI 研究取得了巨大突破,尤其是强化学习 (RL)。尽管取得了成功,但底层游戏通常是使用自己预设的环境和游戏机制实现的,因此研究人员很难为不同的游戏环境设计原型。然而,针对各种游戏环境测试 RL 代理对于最近研究 RL 泛化并避免可能发生的过度拟合问题至关重要。在本文中,我们介绍了 Griddly 作为游戏 AI 研究的新平台,它提供了高度可配置的游戏、不同的观察者类型和高效的 C++ 核心引擎的独特组合。此外,我们还提出了一系列基线实验来研究不同观察配置和 RL 代理泛化能力的影响。

Griddly:游戏人工智能研究平台