机构名称:

¥ 3.0

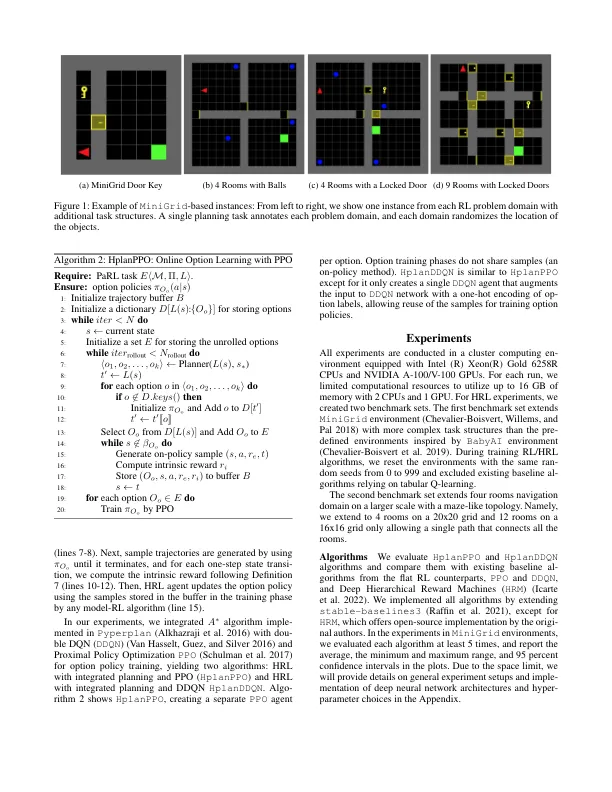

两种常见的顺序决策方法是人工智能规划 (AIP) 和强化学习 (RL)。每种方法都有优点和缺点。AIP 具有可解释性,易于与符号知识集成,并且通常很高效,但需要预先指定逻辑域,并且对噪声敏感;RL 只需要指定奖励,并且对噪声具有鲁棒性,但样本效率低下,不易获得外部知识。我们提出了一种将高级规划与 RL 相结合的综合方法,保留了可解释性、迁移和效率,同时允许对低级规划操作进行鲁棒学习。我们的方法通过在 AI 规划问题的状态转换模型和马尔可夫决策过程 (MDP) 的抽象状态转换系统之间建立对应关系,从 AIP 运算符定义分层强化学习 (HRL) 中的选项。通过添加内在奖励来学习选项,以鼓励 MDP 和 AIP 转换模型之间的一致性。我们通过比较 MiniGrid 和 N 室环境中 RL 和 HRL 算法的性能来展示我们的集成方法的优势,展示了我们的方法相对于现有方法的优势。

具有人工智能规划模型的分层强化学习