机构名称:

¥ 1.0

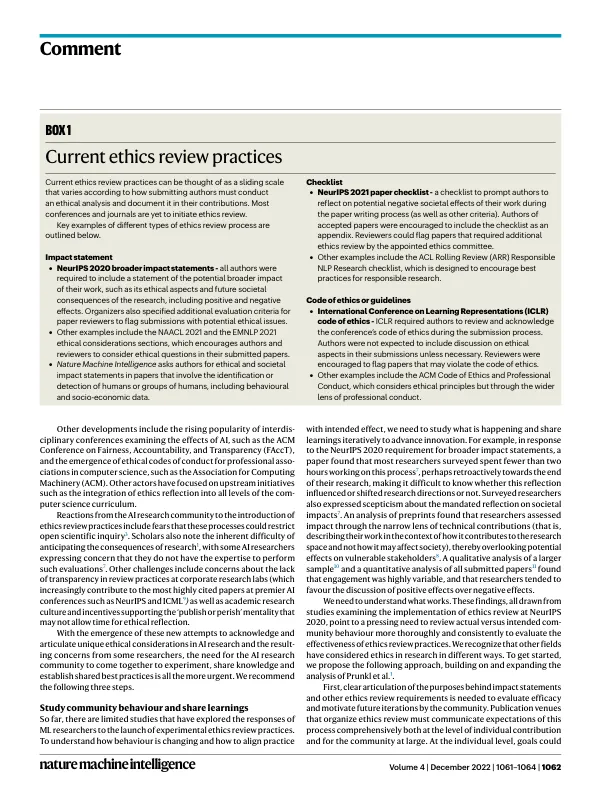

随着人工智能 (AI) 和机器学习 (ML) 技术的不断发展,人们越来越意识到人工智能或机器学习研究对社会可能产生的负面影响。预测和减轻这些后果只能在这项研究的顶尖专家的帮助下实现:研究人员自己。因此,一些领先的人工智能和机器学习组织、会议和期刊已开始实施治理机制,要求研究人员直接面对与其工作相关的风险,这些风险可能包括恶意使用和意外伤害。一些组织已启动新的伦理审查流程,并将其纳入同行评审,主要促进对研究进行后对社会的潜在风险和影响的反思(方框 1)。这与研究人员在研究过程早期承担的其他责任不同,例如保护人类参与者的福利,这些责任由机构审查委员会 (IRB) 等机构管理。虽然这些举措值得称赞,但尚未被广泛采用。这些举措在很大程度上没有得到社区的一致认可。作为人工智能及其治理领域的学术界、行业和非营利组织的研究人员和从业者,我们认为需要社区协调,以确保批判性反思有意义地融入人工智能研究中,以减轻其有害的下游后果。人工智能和机器学习研究的速度及其日益增长的滥用潜力要求今天就进行这种协调。Prunkl 等人在《自然机器智能》上撰文指出,人工智能研究界需要鼓励公众就会议提交的影响声明和其他自我治理机制的优点和未来进行审议。我们同意。在此,我们在此建议的基础上,提出了三项建议,以实现这种有效的社区协调,因为越来越多的伦理审查方法开始出现在会议和期刊中。我们认为,协调一致的社区努力将需要:(1)更多地研究伦理审查流程的影响;(2)更多地试验这些流程本身;(3)创建场所,让人工智能或机器学习社区内外的不同声音可以分享见解并促进规范。尽管我们解决的许多挑战

推进人工智能研究的伦理审查实践

主要关键词