机构名称:

¥ 1.0

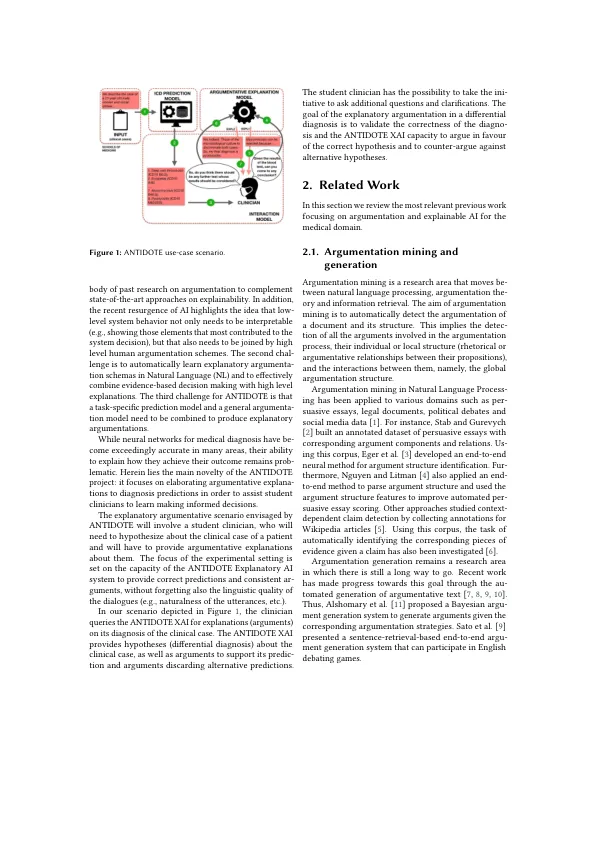

摘要 基于机器学习为人工智能预测提供高质量的解释是一项具有挑战性和复杂性的任务。要使它发挥作用,除其他因素外,它还需要:选择适当的解释的普遍性/特异性水平;考虑解释受益者对所考虑的人工智能任务的熟悉程度的假设;参考有助于决策的具体因素;利用可能不属于预测过程的额外知识(例如专家证据);并提供支持负面假设的证据。最后,系统需要以一种清晰可解释且可能令人信服的方式制定解释。考虑到这些因素,ANTIDOTE 培育了可解释人工智能的综合愿景,其中深度学习过程的低级特征与适合人类论证能力的高级方案相结合。ANTIDOTE 将利用深度学习和论证的跨学科能力来支持更广泛和创新的可解释人工智能观点,其中对临床病例审议的高质量解释至关重要。作为该项目的第一个成果,我们发布了 Antidote CasiMedicos 数据集,以促进可解释人工智能的总体研究,特别是医学领域的论证。

HiTZ@Antidote:基于论证的可解释人工智能,助力数字医疗

主要关键词