机构名称:

¥ 1.0

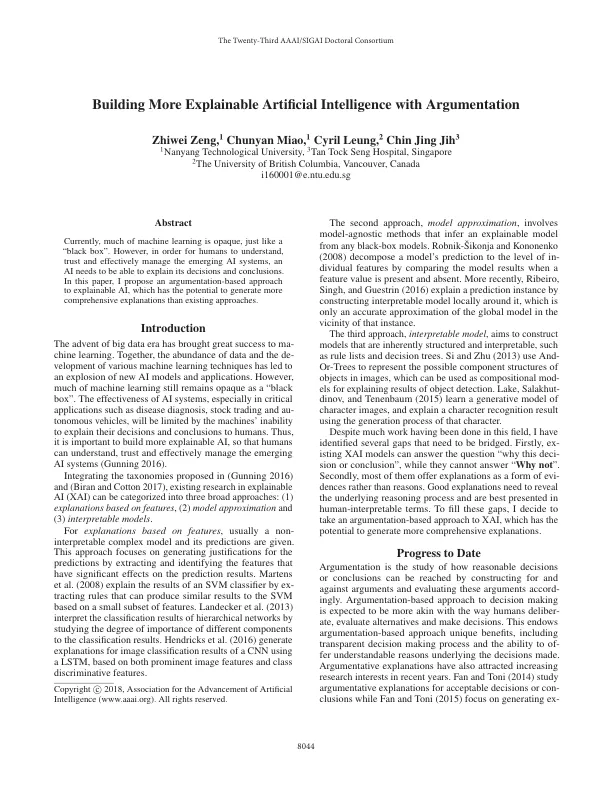

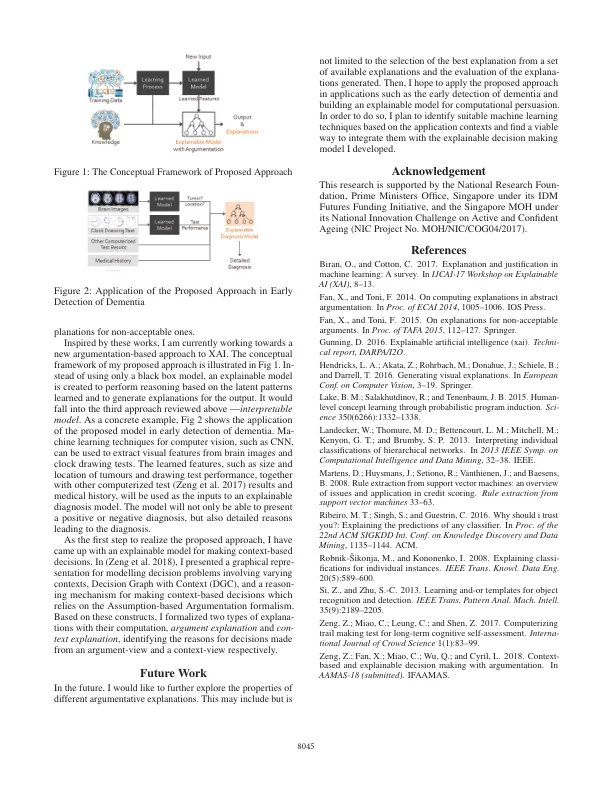

引言大数据时代的到来为机器学习带来了巨大的成功。数据的丰富和各种机器学习技术的发展共同导致了新的人工智能模型和应用的爆炸式增长。然而,机器学习的大部分仍然是不透明的“黑匣子”。人工智能系统的有效性,特别是在疾病诊断、股票交易和自动驾驶汽车等关键应用中,将受到机器无法向人类解释其决策和结论的限制。因此,构建更可解释的人工智能非常重要,这样人类才能理解、信任和有效地管理新兴的人工智能系统(Gunning 2016)。整合(Gunning 2016)和(Biran and Cotton 2017)中提出的分类法,现有的可解释人工智能(XAI)研究可分为三大类方法:(1)基于特征的解释,(2)模型近似和(3)可解释模型。对于基于特征的解释,通常会给出一个不可解释的复杂模型及其预测。这种方法侧重于通过提取和识别对预测结果有显著影响的特征来为预测生成理由。Martens 等人(2008)通过提取可以基于一小部分特征产生与 SVM 类似结果的规则来解释 SVM 分类器的结果。Landecker 等人(2013)通过研究不同组件对分类结果的重要程度来解释分层网络的分类结果。Hendricks 等人(2016)使用 LSTM 基于突出的图像特征和类别判别特征为 CNN 的图像分类结果生成解释。

通过论证构建更可解释的人工智能

主要关键词