机构名称:

¥ 1.0

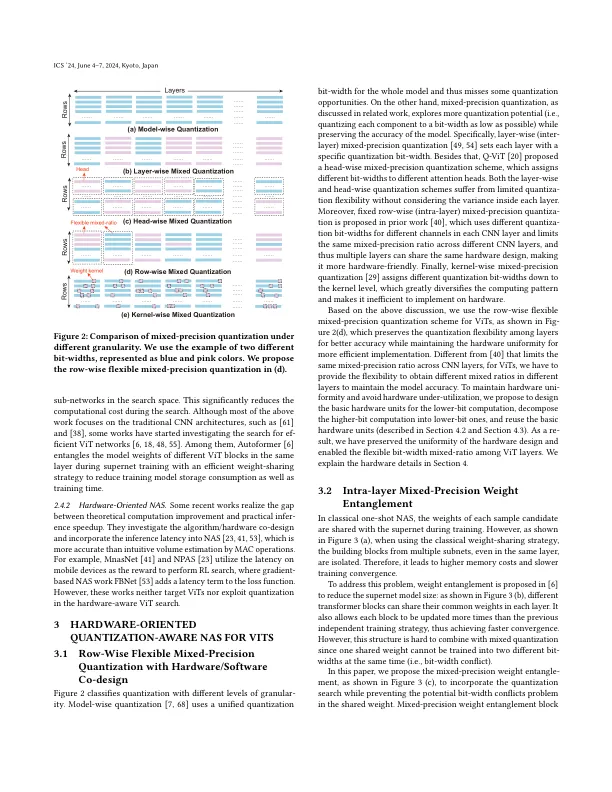

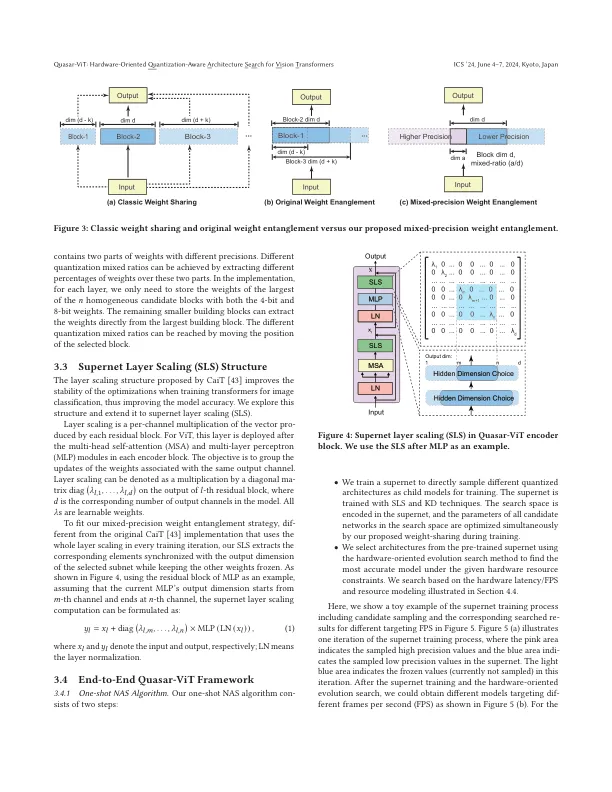

视觉转换器 (ViT) 已证明其在计算机视觉任务中比卷积神经网络 (CNN) 具有更高的精度。然而,为了在资源有限的边缘设备上有效部署,ViT 模型通常需要大量计算。这项工作提出了 Quasar-ViT,一种面向硬件的量化感知 ViT 架构搜索框架,以设计用于硬件实现的高效 ViT 模型,同时保持精度。首先,Quasar-ViT 使用我们的逐行灵活混合精度量化方案、混合精度权重纠缠和超网层缩放技术来训练超网。然后,它应用一种高效的面向硬件的搜索算法,结合硬件延迟和资源建模,从不同推理延迟目标下的超网中确定一系列最佳子网。最后,我们提出了一系列 FPGA 平台上的模型自适应设计,以支持架构搜索并缩小理论计算减少和实际推理加速之间的差距。我们搜索到的模型在 AMD/Xilinx ZCU102 FPGA 上分别实现了 101.5、159.6 和 251.6 帧每秒 (FPS) 的推理速度,对于 ImageNet 数据集的 top-1 准确率分别达到 80.4%、78.6% 和 74.9%,始终优于之前的研究。

Quasar-ViT:面向硬件的视觉变换器量化感知架构搜索

主要关键词