机构名称:

¥ 1.0

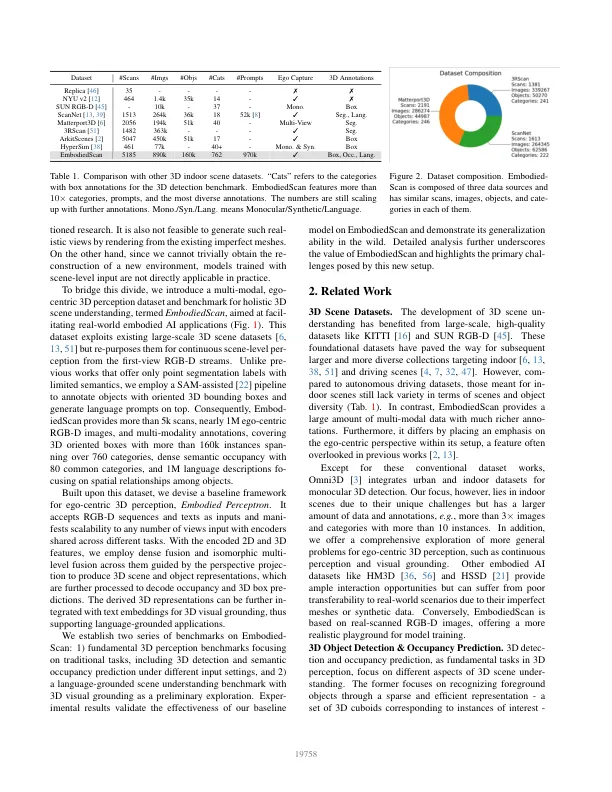

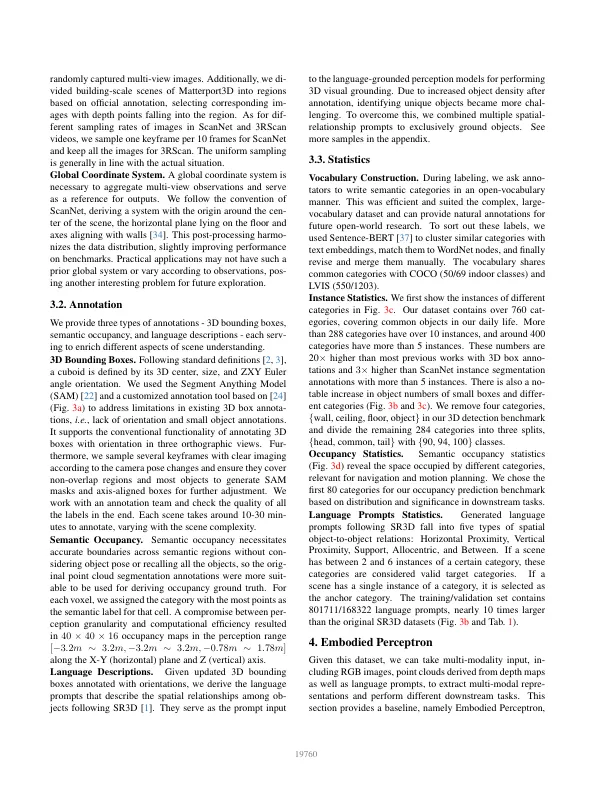

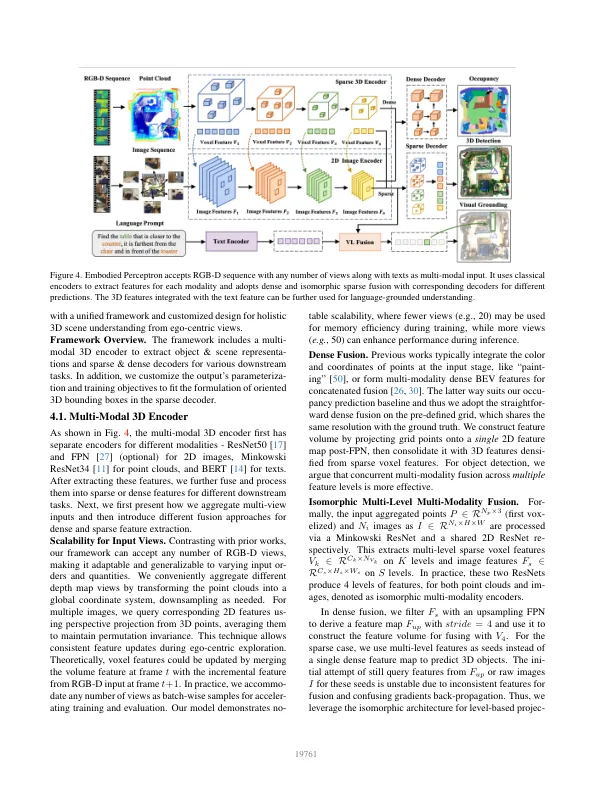

摘要 在计算机视觉和机器人领域,具身代理有望探索其环境并执行人类的指令。 这就需要能够根据第一人称观察充分理解 3D 场景,并将其语境化为语言进行交互。 然而,传统研究更多地侧重于从全局视角进行场景级输入和输出设置。 为了解决这一差距,我们引入了 EmbodiedScan,这是一个多模态、以自我为中心的 3D 感知数据集和整体 3D 场景理解的基准。 它包含超过 5k 个扫描,封装了 1M 个以自我为中心的 RGB-D 视图、1M 个语言提示、160k 个 3D 导向框,涵盖 760 多个类别,其中一些与 LVIS 部分一致,以及具有 80 个常见类别的密集语义占用率。 基于这个数据库,我们引入了一个名为 Embodied Perceptron 的基线框架。它能够处理任意数量的多模态输入,并表现出卓越的 3D 感知能力,无论是在我们建立的两个系列基准测试(即基本 3D 感知任务和基于语言的任务)中,还是在野外。

EmbodiedScan:面向具身 AI 的整体多模式 3D 感知套件