机构名称:

¥ 1.0

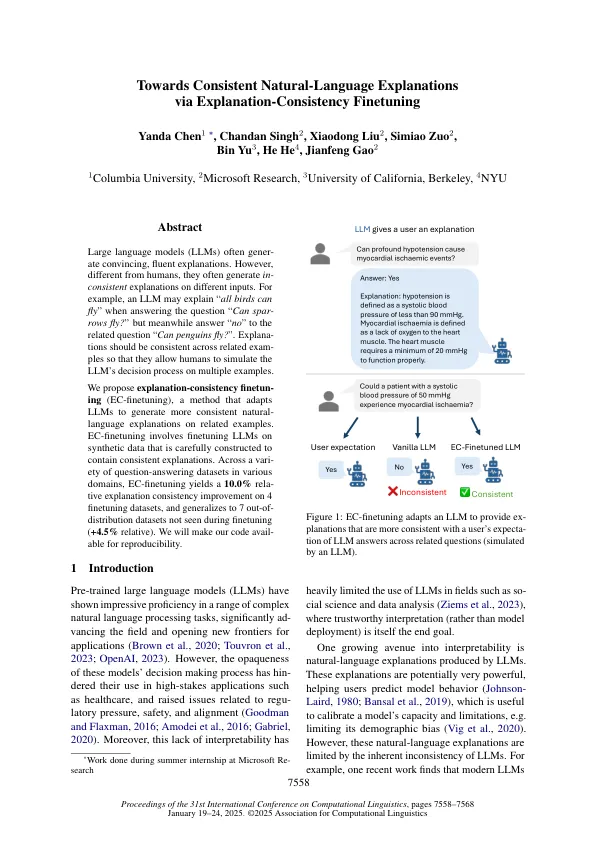

经常会产生不一致的解释,并在非常相关的问题上进行解释(Chen等人,2023b)。实际上,LLMS甚至常常难以回答同一问题的重塑(Sclar等人,2023;张等。,2023)。目前尚不清楚适应LLM的流行方法,例如从人类反馈中监督的填充或加强学习能够解决此问题。我们通过引入解释 - 一致性登录(EC-FINETUNING)来解决此问题。ec-芬特列列列列斯在合成数据上的LLM精确构建以包含一致的规定。我们从一个问题解释对开始(例如,麻雀可以飞吗?”,“所有的鸟都可以飞”),产生一组相关问题(例如,“可以飞翔?”),然后回答与初始解释一致的相关问题(例如,“所有鸟类都可以飞行,以便企鹅可以飞”)。我们通过提示LLM来生成综合数据,这可能与解释LLM相同或不同。我们将EC-FINETIND应用于提问数据集,并发现它在四个芬口数据集中将自然语言解释的一致性提高了10.0%,也将七个分发数据集的概括( +4.5%相对)概括为七个未见到的数据集( +4.5%)。这表明EC-Finetuning通常对于帮助用户从其解释中构建LLM的心理模型很有用(见图1)。

通过解释 - 一致性的芬特培养