机构名称:

¥ 1.0

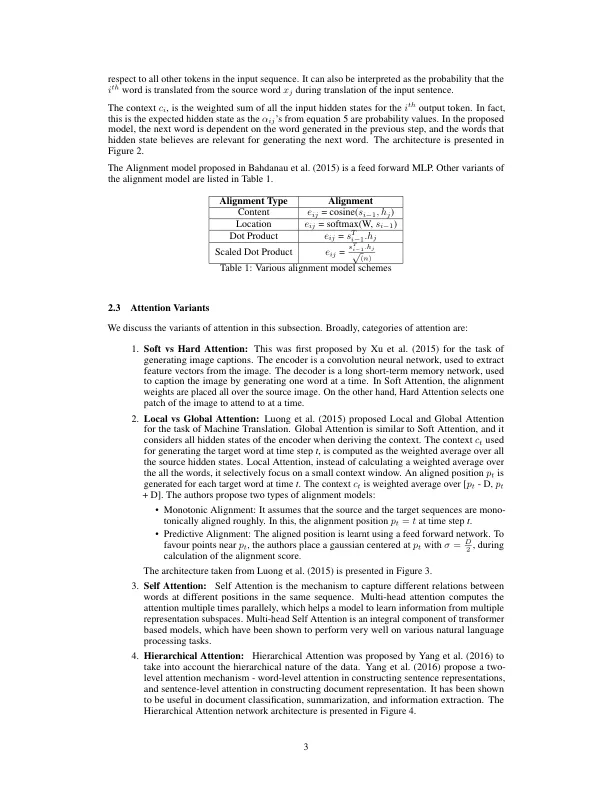

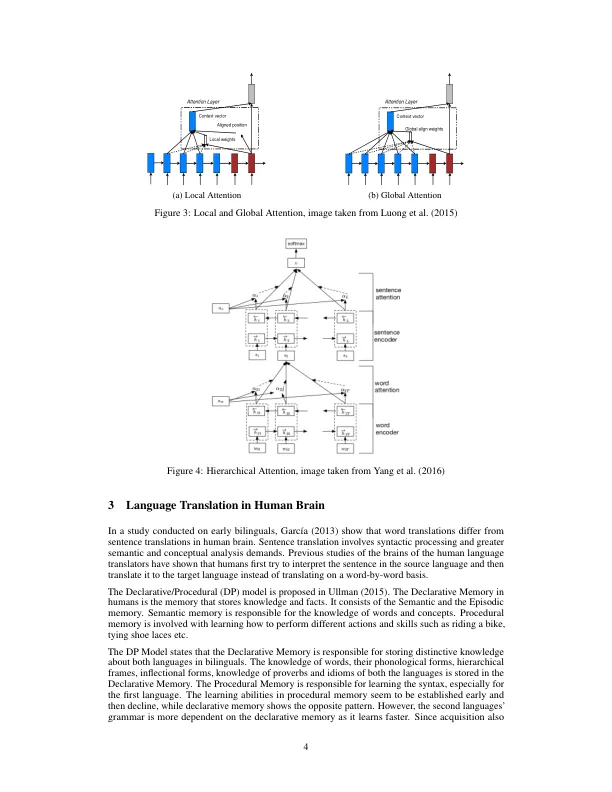

Bahdanau等人提出的基本注意机制。(2015)对于机器翻译而言,通过学习将目标语言与源语言中的单词保持一致,并通过学习目标语言的语言模型来对齐单词。目标序列是基于上一个单词和上下文生成的,从根本上讲,这是源和目标语言中的单词之间的映射。García(2013)表明,语言解释者用一种语言解释句子,然后将其翻译成另一种语言,而不是按单词的基础进行翻译。Ullman(2015)研究的双语中的语言获取过程提出了类似的声明/程序模型,其中不同类型的记忆负责学习两种语言的语法以及有关单词和概念的语义知识。

理解注意力:在思想和机器上