机构名称:

¥ 1.0

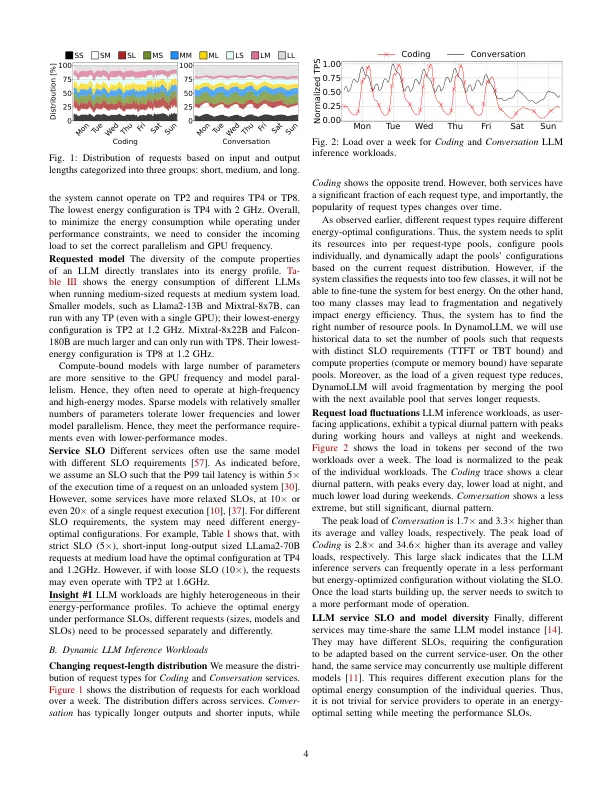

摘要 - 生成大语言模型(LLM)的快速发展和广泛采用使它们成为各种应用程序中的关键工作量。今天,LLM推理群集会收到大量具有严格服务级别目标(SLO)的查询。为了达到所需的性能,这些模型在渴望的GPU上执行,从而导致Interence簇消耗大量能量,并且因此导致过多的碳发射。幸运的是,我们发现有一个很好的机会来利用推理计算属性和推理工作载荷中的波动的异质性,以显着提高能源效率。但是,如此多样化且动态的环境在不同的系统配置中创建了一个较大的搜索空间(例如,,实例数量,模型并行性和GPU频率)转化为不同的绩效权衡。为了应对这些挑战,我们提出了Dynamollm,这是LLM推理环境的第一个能源管理框架。dynamollm会自动,动态地重新配置推理群集,以优化服务性能SLO下的LLM服务的能量和成本。我们表明,在服务级别,Dynamollm可以保留53%的能源和38%的运营碳排放,并在满足潜伏期SLOS的同时,为客户降低了61%的成本。

dynamollm:设计LLM推理群集的性能和能源效率

主要关键词