机构名称:

¥ 1.0

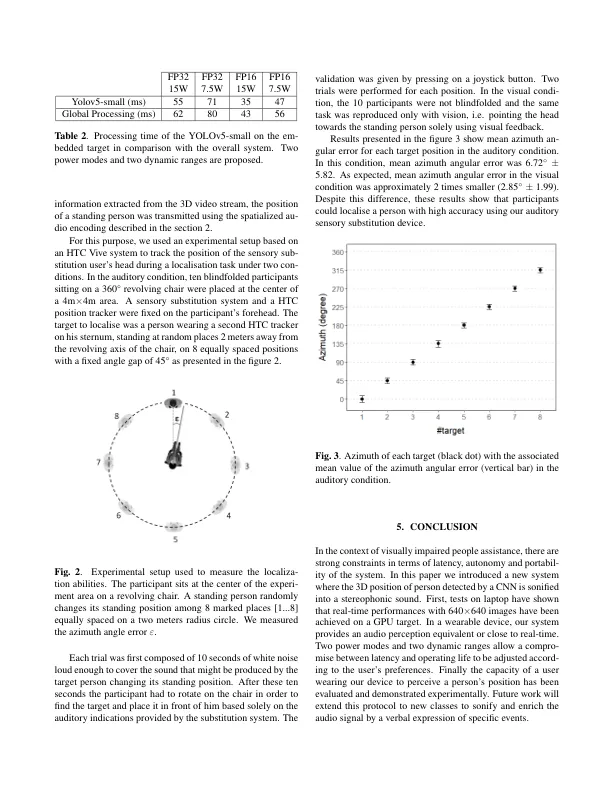

本文提出了一种视觉听觉替代方法,以帮助视障人士理解场景。我们的方法侧重于在用户附近进行人员定位,以方便在城市中行走。由于在这种情况下出于用户安全的考虑,需要实时和低延迟,因此我们提出了一种嵌入式系统。该处理基于轻量级卷积神经网络,以执行有效的 2D 人员定位。该测量结果通过相应的人员深度信息得到增强,然后通过头部相关传递函数转录为立体声信号。本文提出了一种基于 GPU 的实现,可以在 640x480 视频流上以 23 帧/秒的速度实现实时处理。我们通过实验表明,该方法可以实现实时准确的基于音频的定位。

基于实时视觉分析的低延迟人机听觉接口

主要关键词