机构名称:

¥ 2.0

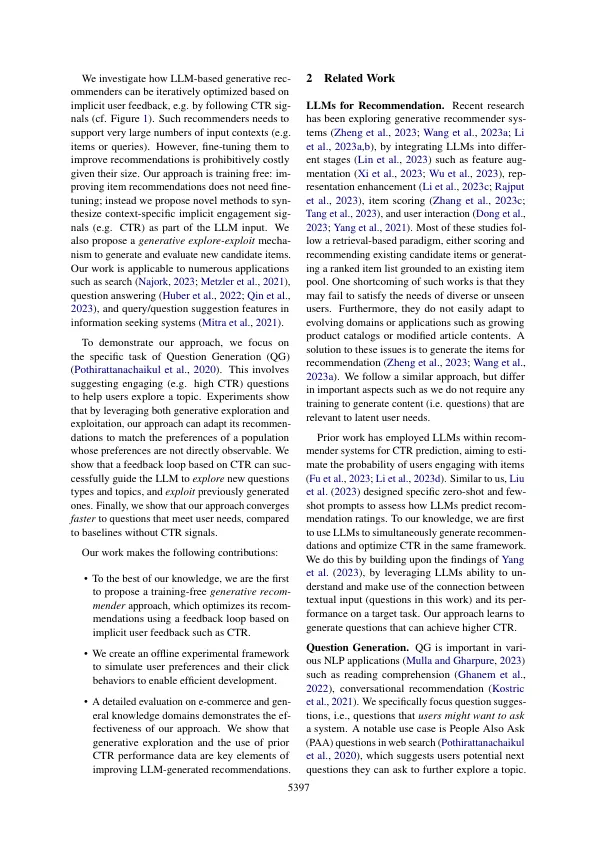

推荐系统被广泛用于吸引参与内容,大型语言模型(LLMS)引起了生成推荐人。这样的系统可以直接构成项目,包括用于诸如问题建议之类的开放设定任务。虽然LLMS的世界知识启动了好的建议,但是通过用户反馈改善生成的内容却是一项挑战,因为持续细微的LLM持续昂贵。我们提出了一种无培训方法,可以通过将用户反馈循环与基于LLM的优化器连接起来来优化生成推荐人。我们提出了一种生成探索探索方法,该方法不仅可以利用具有已知高参与度的生成的项目,而且可以积极地探索并发现隐藏的人群偏爱以提高建议质量。我们在两个域(电子商务和一般知识)中评估了问题生成的方法,并使用单击“速率”(CTR)对用户反馈进行了模型。实验表明,我们基于LLM的探索探索方法可以依靠地提高建议,并同意增加CTR。消融分析表明,生成探索是学习用户偏好的关键,避免了贪婪的仅剥削方法的陷阱。人类评估强烈支持我们的定量发现。

生成探索 - 开发:使用LLM优化器对生成推荐系统进行无培训优化