机构名称:

¥ 1.0

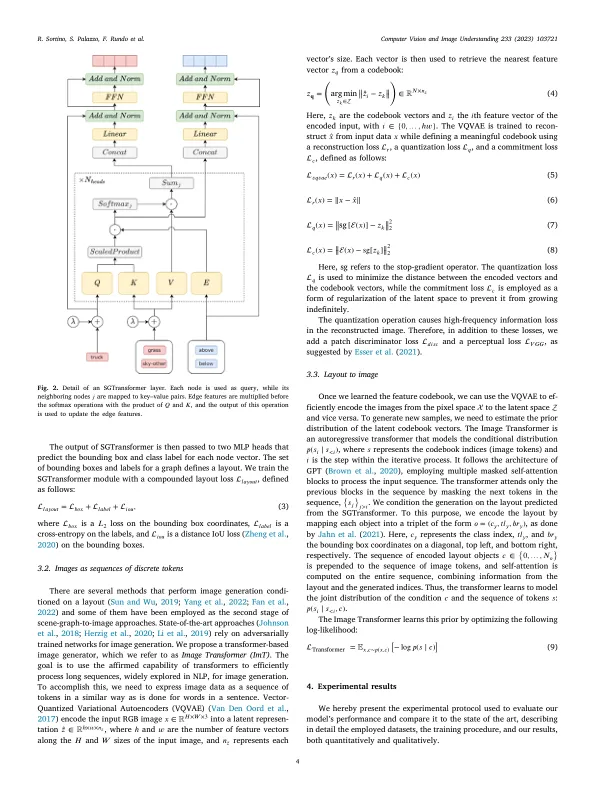

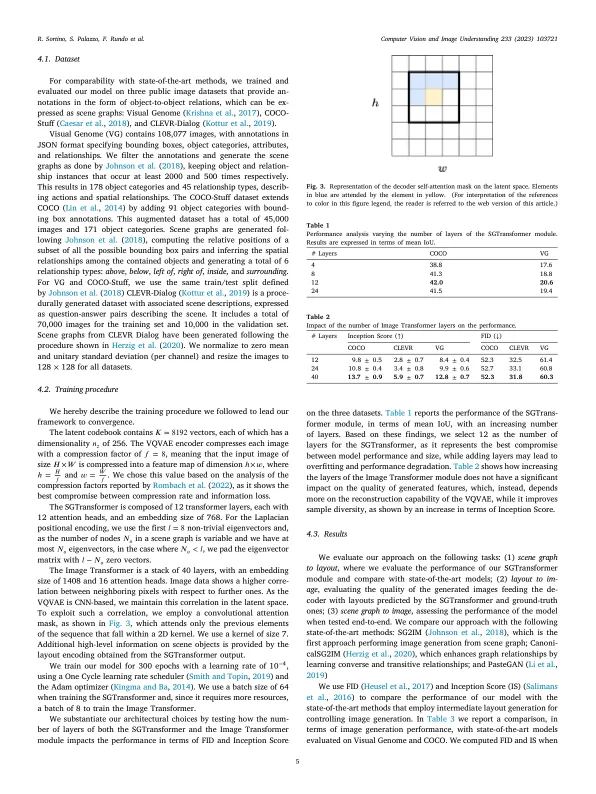

图形结构的场景描述可以在生成模型中有效地使用,以控制生成的图像的组成。以前的方法基于图形卷积网络和对抗方法的组合,分别用于布局预测和图像生成。在这项工作中,我们展示了如何利用多头关注来编码图形信息,以及在潜在的图像生成中使用基于变压器的模型可以提高采样数据的质量,而无需在训练稳定性方面采用后续的对抗模型。所提出的方法,具体来说,完全基于用于将场景图编码为中间对象布局的变压器体系结构,并将这些布局解码为图像,通过矢量定量的变异自动编码器所学到的较低维空间。我们的方法在最新方法中显示出改进的图像质量,以及从同一场景图中的多代人之间的较高程度的多样性。我们在三个公共数据集上评估了我们的方法:视觉基因组,可可和CLEVR。我们在可可和视觉基因组上分别达到13.7和12.8的成立分数和52.3和60.3的FID。我们对我们的贡献进行消融研究,以评估每个组件的影响。代码可从https://github.com/perceivelab/trf-sg2im获得。

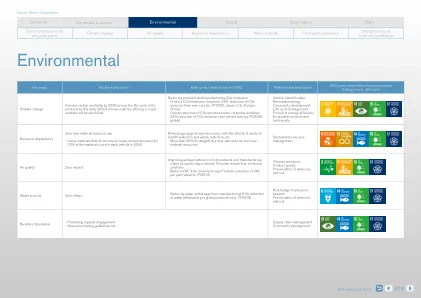

比较了地球的环境生命周期表现 -

主要关键词