机构名称:

¥ 1.0

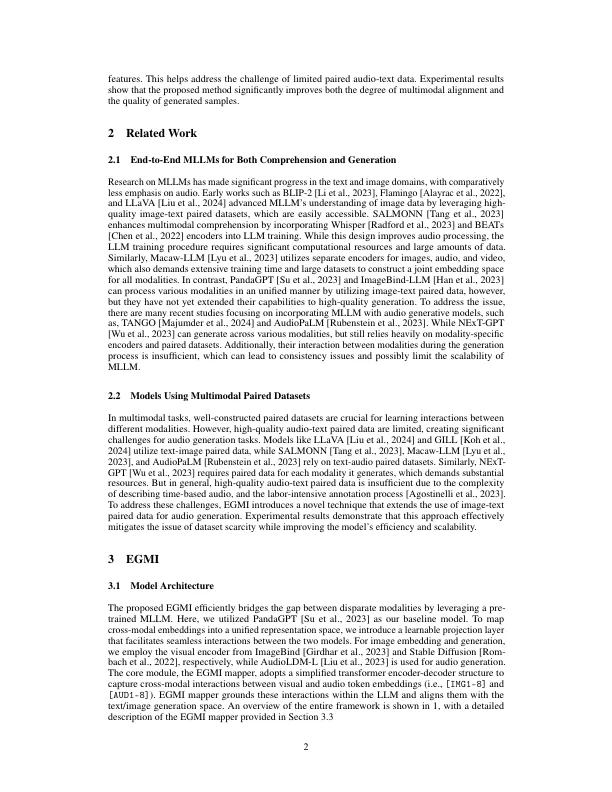

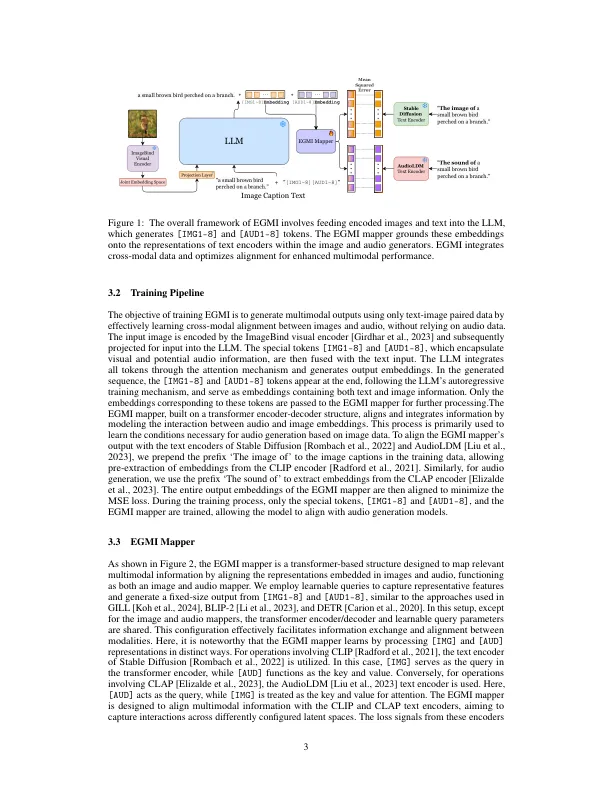

多模式的大语言模型(MLLM)在利用其丰富知识的挑战中面临挑战,因为跨越不同的模式是不平凡的,并且它们的上下文歧义是由于缺乏配对数据而引起的。在基于MLLM的音频生成的背景下,音频文本配对数据集的注释需要大量的人力资源,这是由于音频数据的复杂性,这使与图像text配对数据集相比,此类数据集越来越难以访问。为了解决这些问题,我们提出了一种称为高效生成多模式集成(EGMI)的新技术,该技术仅利用图像 - 文本数据来实现音频生成任务。基于验证的LLM关于文本理解的强大知识,EGMI成功利用图像文本配对的数据集进行跨模式对齐,从而使音频和图像信息之间的交互作用。我们还引入了一个高效的映射网络,称为EGMI映射器,并在生成音频数据时使用它来参与图像信息。因此,我们已经扩大了现有方法的限制,从可伸缩性和灵活性方面。此外,我们已经证明了EGMI最大程度地提高了交叉模式知识,改善对准和样本质量之间的相互作用。

有效的生成多模式集成(EGMI)

主要关键词