机构名称:

¥ 1.0

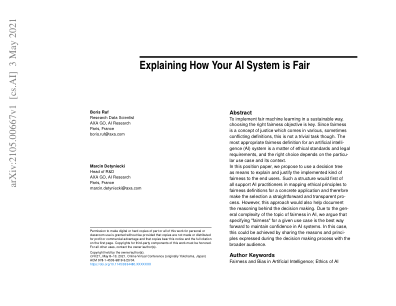

抽象的机器学习(ML)模型,明显强大,缺乏解释性。缺乏透明度,通常被称为ML模型的黑匣子性质,破坏了信任,并敦促需要提高其解释性的努力。可解释的AI(XAI)技术通过提供框架和方法来解释这些复杂模型的内部决策过程,以应对这一挑战。诸如反事实解释(CF)和特征重要性之类的技术在实现这一目标中起着至关重要的作用。此外,高质量和多样化的数据仍然是强大和可信赖的ML应用程序的基础元素。在许多应用中,用于训练ML和XAI解释器的数据包含敏感信息。在这种情况下,可以使用许多隐私技术来保护数据中的敏感信息,例如差异隐私。随后,由于其反对目标,XAI与隐私解决方案之间发生了冲突。由于XAI技术为模型行为提供了推理,因此它们揭示了相对于ML模型的信息,例如其决策边界,特征值或深度学习模型的梯度,当解释暴露于第三实体时。攻击者可以使用这些解释来启动隐私违反攻击,以执行模型提取,推理和会员攻击。这个难题强调了在理解ML决策和保护隐私之间找到正确平衡的挑战。

数据驱动系统中可解释的AI的隐私影响

主要关键词