机构名称:

¥ 1.0

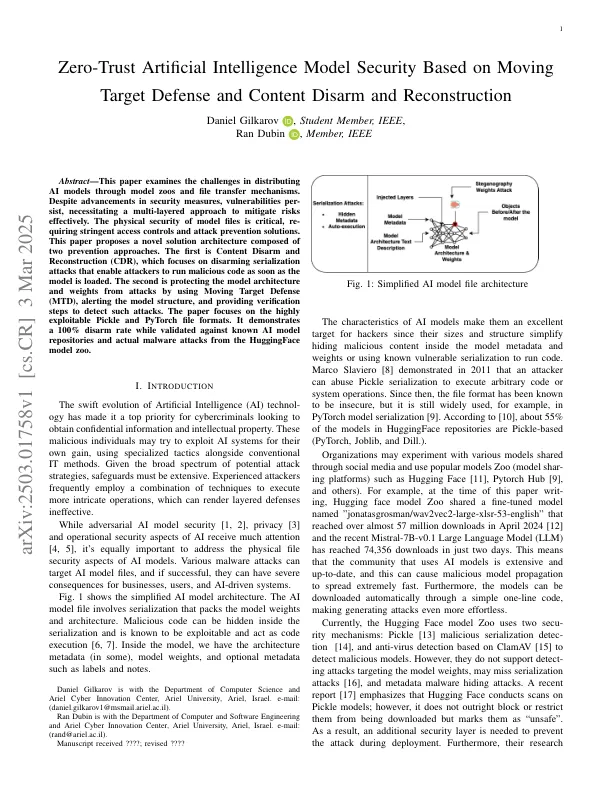

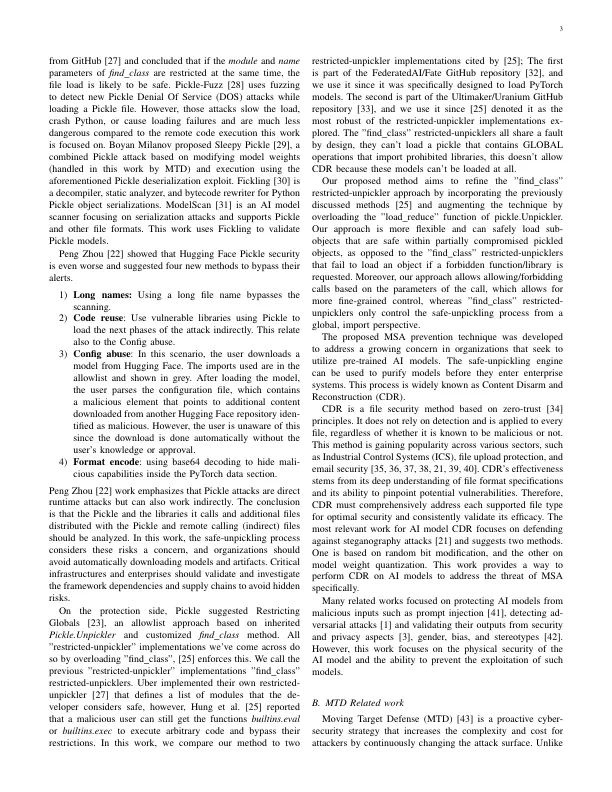

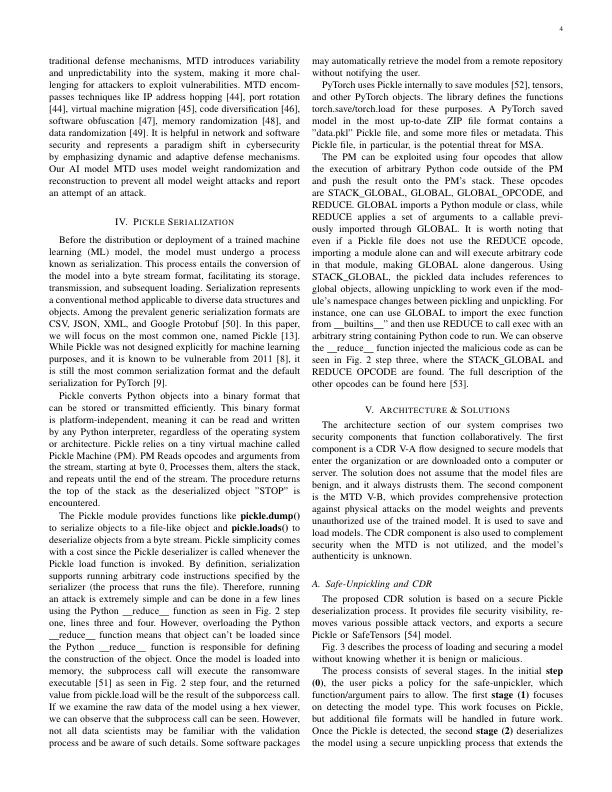

摘要 - 本文研究了通过模型动物园和文件传输机制分发AI模型的挑战。尽管有安全措施的进步,但漏洞仍存在,需要采取多层方法来有效地减轻风险。模型文件的物理安全性至关重要,重新确定了严格的访问控制和攻击预防解决方案。本文提出了一种新的解决方案结构,该结构由两种预防方法组成。第一个是内容解除和重建(CDR),它的重点是解除序列化攻击,使攻击者在加载模型后立即运行恶意代码。第二个是通过使用移动目标防御(MTD)来保护模型体系结构和权重,以免受攻击,警告模型结构并提供验证步骤以检测此类攻击。本文重点介绍了高度可利用的泡菜和Pytorch文件格式。它证明了100%的解除武装率,同时验证了Huggingface模型动物园的已知AI模型存储库和实际恶意软件攻击。

基于移动的零信任人工智能模型

主要关键词