机构名称:

¥ 2.0

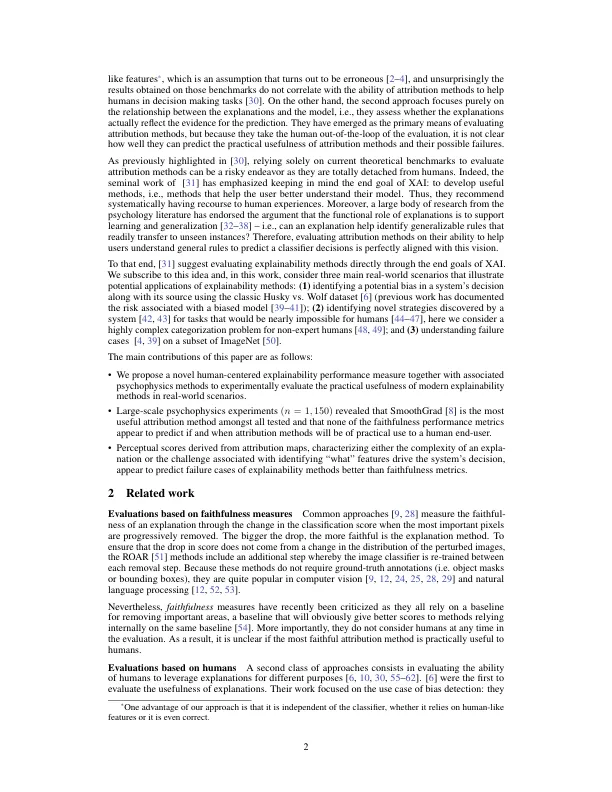

已经描述了多种解释性方法,以帮助用户更好地了解现代AI系统如何做出决策。但是,开发用于评估这些方法的大多数性能指标基本上仍然是理论上的 - 没有太多考虑人类最终用户。尤其尚不清楚(1)在现实世界中,当前解释性方法的有用程度如何; (2)当前的性能指标是否准确地反映了最终用户的解释方法的有用性。为了填补这一差距,我们进行了心理物理学实验(n = 1,150),以评估三种现实世界中代表性归因方法的有用性。我们的结果表明,在这些情况下,各个归因方法可以帮助人类参与者更好地理解AI系统的程度差异很大。这表明需要超越当前归因方法的定量改进,朝着开发互补方法的发展,这些方法为人类最终用户提供了质量不同的信息来源。

我无法预测的,我不明白:一个人 -