机构名称:

¥ 1.0

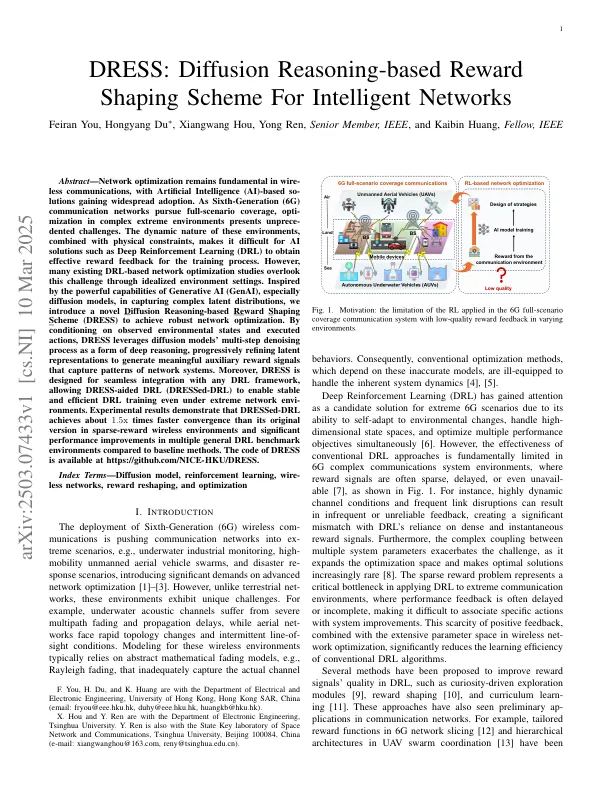

摘要 - 通过人工智能(AI)基于人工智能(AI)基于人工智能的沟通优化仍然是基础的基础。作为第六代(6G)通信网络追求全赛纳里奥的覆盖范围,在复杂的极端环境中的选择提出了未经证实的挑战。这些环境的动态性质,结合物理约束,使AI解决方案(例如深度强化学习(DRL))很难为培训过程获得有效的奖励反馈。但是,许多现有的基于DRL的网络优化研究通过理想化的环境设置忽略了这一挑战。受到生成AI(Genai)(尤其是扩散模型)的强大功能的启发,在捕获复杂的潜在分布时,我们引入了一种新颖的基于扩散推理的奖励成型方案(着装),以实现强大的网络优化。通过对观察到的环境状态进行调节和执行动作,着装利用扩散模型的多步降级过程作为深层推理的一种形式,逐渐完善了潜在表示,以产生有意义的辅助奖励信号,以捕获网络系统模式。此外,连衣裙设计用于与任何DRL框架的无缝集成,允许连衣裙辅助的DRL(装扮得出)即使在极端的网络环境下也可以实现稳定而有效的DRL培训。实验结果表明,穿着的DRL大约达到1。礼服代码可从https://github.com/nice-hku/dress获得。与基线方法相比,在稀疏奖励无线环境中的收敛速度比其原始版本快于其原始版本,并且在多个一般DRL基准环境中的性能得到了显着改进。

着装:智能网络基于扩散推理的奖励成型方案

主要关键词