机构名称:

¥ 1.0

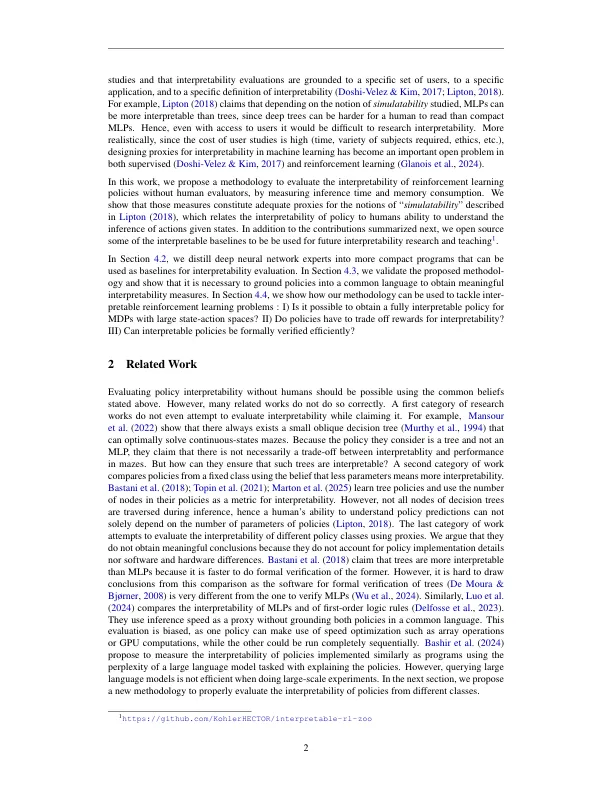

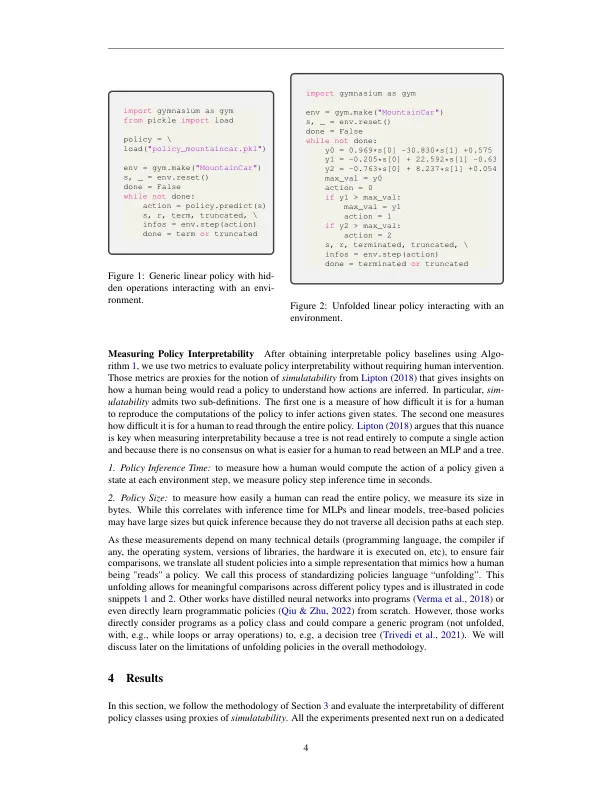

存在强化学习之类的应用,例如医学,其中政策需要被人类“解释”。用户研究表明,某些政策类可能比其他政策类更容易解释。但是,进行人类的政策解释性研究是昂贵的。此外,没有明确的解释性定义,即没有明确的指标来解释性,因此主张取决于所选的定义。我们解决了通过人类解释性的经验评估政策的问题。尽管缺乏明确的定义,但研究人员对“模拟性”的概念达成了共识:政策解释性应与人类如何理解所给出的政策行动有关。为了推进可解释的强化学习研究,我们为评估政策解释性做出了新的方法。这种新方法依赖于代理来进行模拟性,我们用来对政策解释性进行大规模的经验评估。我们使用模仿学习来通过将专家神经网络提炼为小程序来计算基线政策。然后,我们表明,使用我们的方法来评估基准解释性会导致与用户研究相似的结论。我们表明,提高可解释性并不一定会降低表现,有时会增加它们。我们还表明,没有政策类别可以更好地跨越各个任务的可解释性和绩效进行交易,这使得研究人员有必要拥有比较政策可解释性的方法。

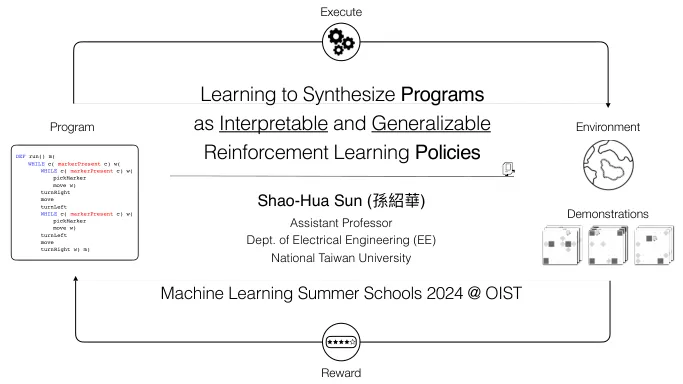

通过将政策提炼为程序来评估可解释的强化学习