机构名称:

¥ 1.0

亚马逊,美国西雅图的应用科学家实习生,美国05/2021-08/2021•我们提出了一个基于相互信息共同培训(MICO)的选择性搜索框架(通过相似性将文档聚集到群体,并仅在其最相关的组中搜索每个查询)。与搜索所有文档相比,我们将搜索成本降低到5%,达到99%的准确性。•MICO是端到端的学习模型。其目标函数是查询的两个组索引及其相关文档之间的共同信息,这两者都是可训练的神经网络的输出。•在我的实施中,该模型将BERT表示为输入(查询或文档标题)作为输入,并且可以在巨大的数据集(数百GB)上有效培训,并且BERT也可以进行列出。•MICO的论文被Coling 2022接受为口头呈现(10%)。

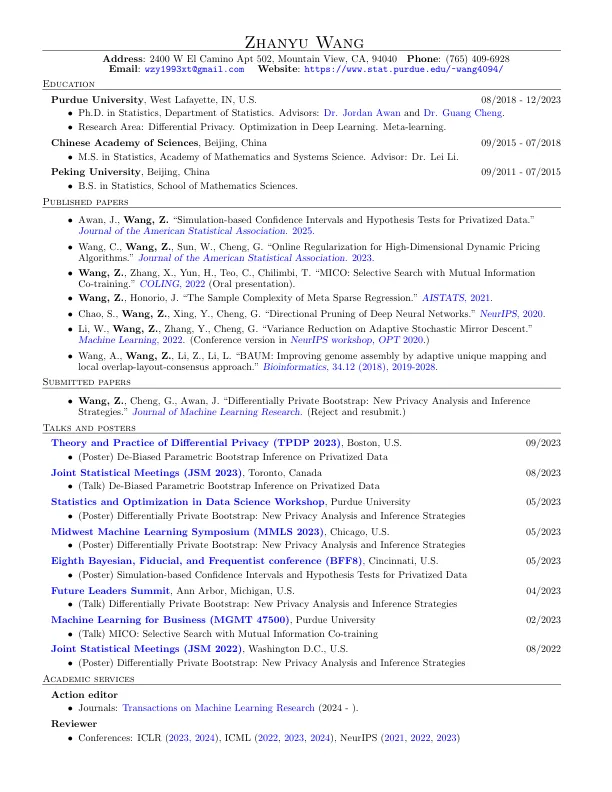

Zhanyu Wang-普渡大学统计局

主要关键词