机构名称:

¥ 1.0

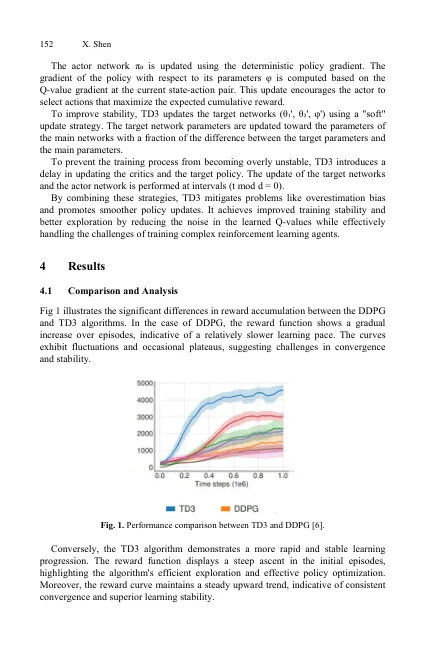

摘要。强化学习已成为一种强大的方法,用于解决各个领域的复杂连续控制任务。本文对两种突出的强化学习算法进行了广泛的比较分析:深层确定性策略梯度(DDPG)算法及其高级对应物,即Twin删除的DDPG(TD3)算法。主要的重点是评估这些算法在运动控制领域内的性能和有效性,这是一个具有实质性现实世界的领域。本研究以Walker2D问题为中心,Walker2D问题是一项具有挑战性的机能控制任务,可在OpenAI Gym环境中提供。walker2d预示着令人信服的测试床,用于评估在机器人技术,自主系统和物理控制等上下文中增强学习算法的实用性。通过对DDPG和TD3进行详细检查,作者旨在阐明其在连续控制场景中的优势和劣势。超出了学术利益,这项研究具有重要的现实意义。掌握连续控制任务对从机器人技术和自动化到医疗保健及其他地区的应用具有巨大的希望。本质上,这项研究弥合了在强化学习方面的理论进步与解决现实世界挑战方面的实际含义之间的差距。通过在苛刻的运动控制背景下对这些算法进行全面评估,这项工作有助于更广泛地理解重新学习学习的潜力,以推动各种行动中的创新和效率。

在Walker2D方案中DDPG和TD3算法的比较

主要关键词