机构名称:

¥ 1.0

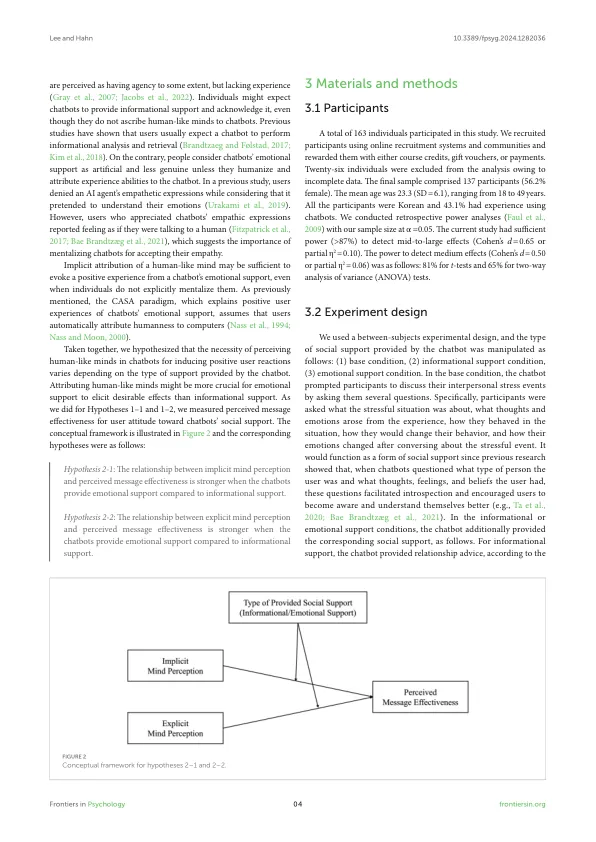

聊天机器人提供的社会支持通常是为了模仿人类支持他人的方式。但是,与信息支持相比,个人对聊天机器人的态度更加矛盾(例如,同理心和鼓励)(例如,有用的信息和建议)。这种差异可能与个人是否将某种类型的支持与人类思想领域相关联,以及他们是否将类似人类的思想归因于聊天机器人。在本研究中,我们调查了聊天机器人中的人类思想是否会影响用户接受聊天机器人提供的各种支持。在实验中,聊天机器人提出了有关参与者的人际压力事件的问题,促使他们写下压力很大的经历。根据实验条件,聊天机器人提供了两种社会支持:信息支持或情感支持。我们的结果表明,当参与者在聊天机器人中明确看出类似人类的思想时,他们认为支持对解决压力事件更有帮助。隐式思维感知和感知的信息有效性之间的关系因支持类型而有所不同。更具体地说,如果参与者没有隐式将类似人类的思想归因于聊天机器人,则情感支持破坏了信息的有效性,而信息支持则不会。目前的发现表明,用户的思想感知对于了解聊天机器人社会支持的用户体验至关重要。我们的发现意味着在建立社会支持聊天机器人时可以信任信息支持。相比之下,情感支持的有效性取决于用户隐含地给聊天机器人一个人的头脑。

关于聊天机器人的思想感知与社会支持之间的关系