机构名称:

¥ 2.0

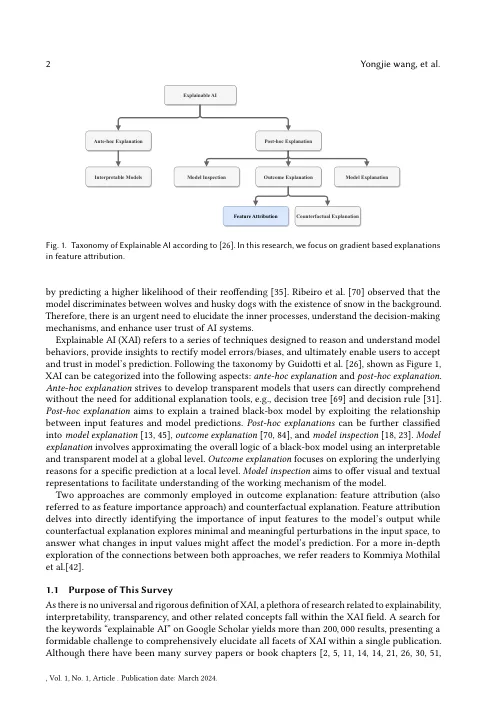

Black-Box AI模型的激增促使需要解释内部机制并证明其可靠性是合理的,尤其是在高风险应用中,例如医疗保健和自动驾驶。由于缺乏对可解释的AI(XAI)的严格定义,已经开发了与解释性,可解释性和透明度有关的大量研究,以从各个角度解释和分析该模型。因此,通过详尽的论文清单,从各个方面对XAI研究进行全面概述变得具有挑战性。考虑到神经网络在AI研究中的普及,我们将重点缩小到XAI研究的特定领域:基于梯度的解释,可以直接用于神经网络模型。在这篇综述中,我们系统地探讨了迄今为止基于梯度的解释方法,并引入了一种新颖的分类法,将它们分类为四个不同的类别。然后,我们按时间顺序介绍了技术细节的本质,并强调了算法的演变。接下来,我们引入人类和定量评估以测量算法性能。更重要的是,我们证明了XAI中的一般挑战以及基于梯度的解释中的特定挑战。我们希望这项调查能够帮助研究人员了解最先进的进步及其相应的缺点,这可能引发他们对解决未来工作中这些问题的兴趣。

基于梯度的特征归因于可解释的AI

主要关键词