机构名称:

¥ 3.0

2020)设置。但是,大多数现有的解决方案都是根据对手遗忘的关键假设建立的,这意味着损失功能的变化不取决于代理的历史轨迹。这个关键的假设限制了无重组算法对许多RL字段的适用性,尤其是多代理增强学习(MARL)(Yang and Wang,2020)。在一个多代理系统中,由于所有代理人都在同时学习,因此一个代理商对其策略的改编将使环境从其他代理商的角度来看。因此,要找到每个玩家的最佳策略,必须考虑他人的战略反应,而不是纯粹是遗忘的。因此,研究非固定算法针对非合理的对手是将现有在线学习技术调整为MARL设置的关键步骤。在线学习中的另一个挑战是系统中的非连面动态。当代理应用无需重格算法(例如乘法更新)(MWU)(Freund and Schapire,1999)或关注正规领导者(FTRL)(Shalev-Shwartz等人),2011年)要互相对抗,该系统展示了庞加莱经常性的行为(Mertikopoulos等人。,2018年),这意味着永远无法实现最后一轮融合(Bailey and Piliouras,2018)。最近的作品(Dinh等人,2021a; Daskalakis和Panageas,

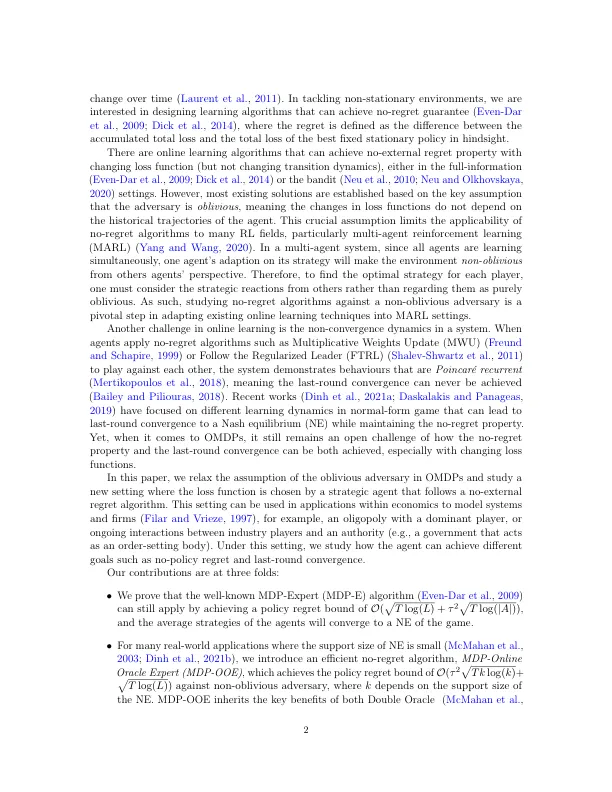

OMDP,具有非稳定的战略对手

主要关键词