机构名称:

¥ 1.0

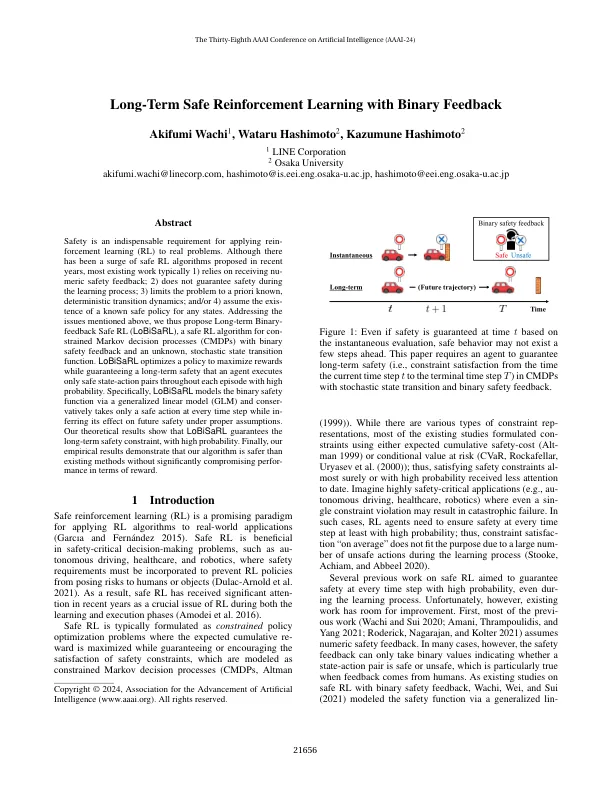

安全是将重新执行学习(RL)应用于实际问题的必不可少的要求。尽管近年来提出了大量的安全RL算法,但大多数现有工作通常1)依赖于收到Nu-ereric Safety Affect的反馈; 2)不能保证在学习过程中的安全; 3)将问题限制为先验已知的确定性过渡动力学;和/或4)假设对任何州的已知安全政策都具有关注。解决上述问题时,我们提出了长期的二进制反馈安全RL(LOBISARL),这是一种具有二进制安全反馈和未知的随机状态过渡功能的马尔可夫决策过程(CMDP)的安全RL算法。lobisarl优化了一项政策,以最大程度地提高奖励,同时保证代理商在每个情节中仅执行安全的州行动对,并以很高的可能性执行安全的州行动对。具体来说,Lobisarl通过广义线性模型(GLM)对二进制安全函数进行建模,并且在每个时间步骤中仅采取安全措施,同时在适当的假设下对未来的安全产生影响。我们的理论结果表明,Lobisarl具有很高的可能性,可以保证长期的安全限制。最后,我们的经验结果表明,我们的算法比现有方法更安全,而没有显着损害奖励方面的表现。

二进制反馈

主要关键词